Kako namestiti lokalni jezikovni model?

Takšen pristop je omogočil hitro širitev tehnologije, hkrati pa je ustvaril novo odvisnost od centralizirane infrastrukture, zunanjih ponudnikov in stalne internetne povezave. Prav zaradi teh omejitev se v tehničnih krogih vse pogosteje pojavlja interes za lokalno namestitev in uporabo jezikovnih modelov, kjer se celotna obdelava izvaja na uporabnikovem računalniku ali interni infrastrukturi.

Vendar pa lokalna raba zahteva drugačen način razmišljanja, natančno razumevanje omejitev in premišljeno izbiro orodij ter modelov.

Kaj sploh pomeni uporabljati lokalni jezikovni model?

Lokalna namestitev pomeni, da je jezikovni model fizično shranjen na uporabnikovem sistemu in se tam tudi izvaja. LLM se ob zagonu naloži v pomnilnik in izvaja proces sklepanja, pri katerem na podlagi vhodnega besedila generira izhodno. Pomembno je poudariti, da lokalna raba skoraj vedno pomeni uporabo že naučenih modelov. Učenje modelov od začetka je računsko izjemno zahtevno in presega zmožnosti osebnih računalnikov.

Ključna razlika v primerjavi z oblakom je nadzor. Podatki ne zapuščajo sistema, ni odvisnosti od zunanjih strežnikov, hkrati pa uporabnik prevzame vso odgovornost za delovanje, stabilnost in varnost.

Kakšno strojno opremo potrebujete za uporabo lokalnih LLM-jev?

Pri lokalnih jezikovnih modelih procesor ni glavni omejitveni dejavnik. Najpogostejša ozka grla so količina sistemskega pomnilnika (RAM) in, pri uporabi grafične kartice, količina video pomnilnika. Model z več milijardami parametrov lahko tudi v kvantizirani obliki zahteva več gigabajtov RAM-a. Na sistemih s 16 GB pomnilnika lahko realno uporabljamo manjše in srednje modele, pri 32 GB pa se nabor možnosti bistveno razširi.

Grafična kartica močno izboljša odzivnost, vendar ni nujna. Veliko uporabnikov lokalne modele poganja izključno na procesorju. Apple sistemi so v tem pogledu specifični, saj omogočajo učinkovito rabo enotnega pomnilnika, kar pogosto daje boljše rezultate kot primerljivi sistemi z ločeno grafično kartico.

Zakaj sploh uporabljati lokalni jezikovni model?

Za lokalen zagon LLM-jev se odločajo uporabniki, ki so dosegli točko, ko prednosti oblačnih rešitev več ne odtehtajo njihovih omejitev. Lokalni modeli niso univerzalna zamenjava za oblak, vendar v določenih scenarijih ponujajo jasne in merljive prednosti.

Prvi in najpogostejši razlog je nadzor nad podatki. Pri lokalni rabi noben del besedila, kode ali dokumentacije ne zapusti sistema. V okoljih, kjer se obdelujejo občutljivi podatki, poslovne skrivnosti ali osebni podatki, za katere zakonodaja ali interna pravila prepovedujejo pošiljanje v zunanje storitve, je to zelo pomembno.

Tesno povezan vidik je zasebnost. Tudi kadar oblačni ponudniki zagotavljajo, da podatkov ne uporabljajo za učenje modelov, mora uporabnik zaupati zunanjemu sistemu. Lokalna raba to zaupanje nadomesti z dejstvom, da je nadzor v rokah uporabnika. Slednji natančno ve, kje so shranjeni podatki, kdo ima dostop do sistema in kako se z njimi ravna.

Pomemben razlog je tudi neodvisnost od ponudnikov. Oblačne storitve se lahko spremenijo čez noč: spremenijo se cene, omejitve uporabe, dostop do določenih funkcij ali celo celotna poslovna strategija ponudnika. Lokalni jezikovni model deluje neodvisno od teh odločitev. Ko je enkrat nameščen, ga uporabnik lahko uporablja, prilagaja in nadgrajuje v svojem tempu.

Z vidika stroškov se lokalna raba pogosto izkaže za dolgoročno ugodnejšo. Čeprav začetna investicija v strojno opremo in čas ni zanemarljiva, se pri redni in intenzivni uporabi lokalni model hitro izplača. Ni stroškov na zahtevo, ni omejitev števila pozivov in ni skritih naročnin.

Naslednji razlog je odzivnost in zanesljivost. Lokalni model ne potrebuje internetne povezave. Deluje tudi v zaprtih omrežjih, na terenu ali v okoljih z omejeno povezljivostjo. Odzivni časi so stabilni in predvidljivi, saj niso odvisni od obremenjenosti zunanjih strežnikov ali omrežnih zakasnitev.

Lokalni modeli omogočajo tudi večjo prilagodljivost. Uporabnik lahko model prilagodi specifičnemu področju, ga poveže z lastnimi dokumenti ali omeji njegovo delovanje na določen nabor znanja. Takšna specializacija pogosto prinese boljše rezultate kot uporaba splošnih oblačnih modelov, saj se model uči in deluje znotraj jasno definiranega konteksta.

Nazadnje je tu še vidik razumevanja tehnologije. Uporaba lokalnega jezikovnega modela uporabnika prisili, da razume osnovna načela delovanja, omejitve in možnosti sistema. To znanje je dragoceno, saj omogoča bolj realna pričakovanja in bolj premišljeno uporabo umetne inteligence. Namesto črne skrinjice v oblaku uporabnik dobi orodje, katerega delovanje razume in nadzoruje.

Vse to ne pomeni, da bi moral vsak uporabnik preiti na lokalno rabo. Pomeni pa, da za vse več tehnično pismenih uporabnikov lokalni jezikovni modeli niso več eksotična alternativa, temveč povsem dostojna alternativa, kadar so nadzor, zasebnost in dolgoročna vzdržnost pomembnejši od absolutne zmogljivosti največjih oblačnih sistemov.

Kateri jezikovni model ustreza vam?

Izbira modela je eden najpomembnejših korakov in hkrati najpogostejši vir napačnih pričakovanj. V lokalnem okolju ne obstaja en sam najboljši model. Obstajajo modeli, ki so bolj primerni za določene naloge in omejitve.

Med najbolj razširjenimi so modeli iz družine LLaMA in njihove odprtokodne izpeljanke. Njihova priljubljenost temelji na stabilnem obnašanju, dobrem splošnem razumevanju jezika in izjemno široki podpori v lokalnih orodjih. Ti modeli so pogosto prva izbira za splošno pisanje, povzemanje in analizo besedil.

Zelo pomembno mesto imajo tudi Mistralovi modeli, ki so postali priljubljeni predvsem zaradi učinkovitosti. V primerjavi z večjimi modeli ponujajo zelo dobro razmerje med kakovostjo in porabo virov. Zaradi tega jih pogosto uporabljajo uporabniki z omejenim pomnilnikom ali tisti, ki želijo hitrejše odzive brez večjih kompromisov.

Za razvoj programske opreme se pogosto uporabljajo specializirani modeli za kodo, ki so učeni na večjem deležu izvorne kode. Ti modeli običajno niso najboljši pri splošnem klepetu, vendar so bistveno bolj natančni pri razlagi programske logike, pisanju funkcij in razumevanju obstoječih projektov.

Pri izbiri modela je pomembno razumeti pomen kvantizacije. Kvantizirani modeli zavzamejo manj pomnilnika in omogočajo lokalno rabo tudi na manj zmogljivih sistemih. Pogosto se izkaže, da je srednje velik kvantiziran model bolj uporaben kot zelo velik model, ki deluje na robu zmogljivosti sistema.

Ollama in LM Studio – vrata v svet lokalnih modelov

Lokalna raba LLM-ja bi bila brez sodobnih orodij bistveno težja.

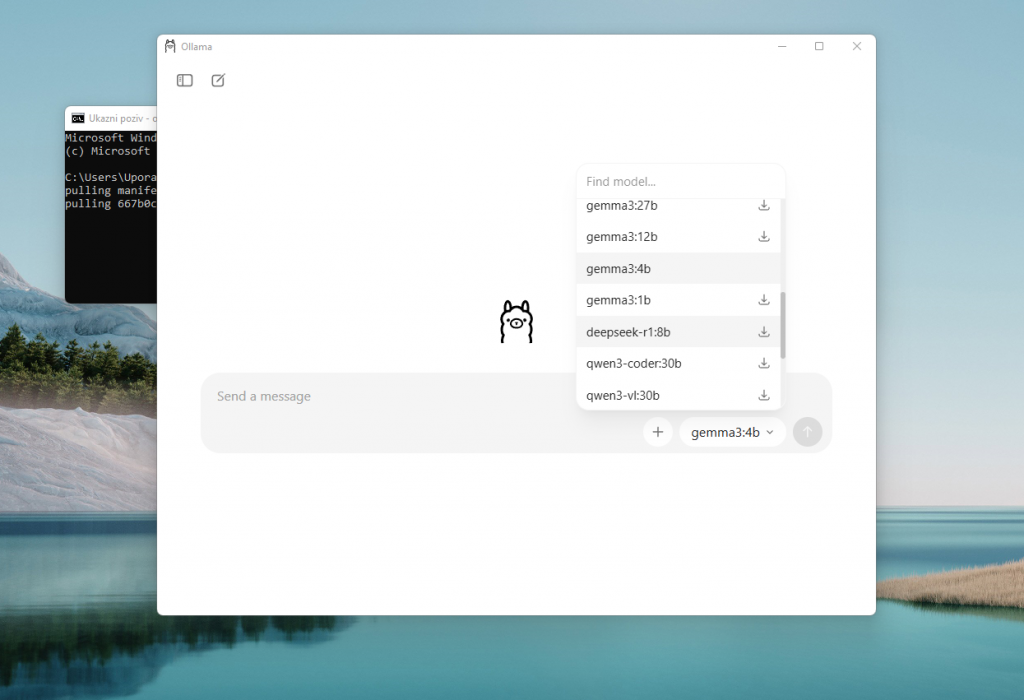

Ena najbolj razširjenih rešitev je Ollama, ki je postala standardna vstopna točka za lokalno rabo. Njena glavna prednost je, da skrije večino tehnične kompleksnosti. Uporabnik ne razmišlja o nalaganju uteži, konfiguraciji izvajalnika ali optimizaciji pomnilnika. Program vse to opravi samodejno, uporabnik pa model zažene z enim ukazom. Zaradi tega je Ollama zelo priljubljena med razvijalci in naprednimi uporabniki, ki želijo stabilno lokalno okolje brez dolgotrajne priprave.

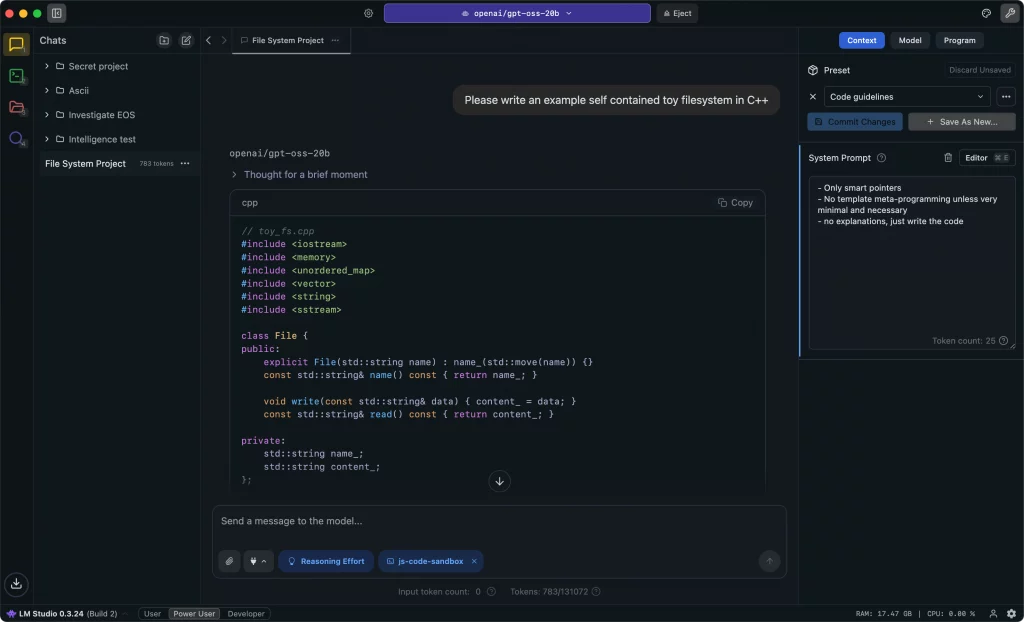

Za tiste, ki želijo grafični vmesnik, je pogosta izbira LM Studio, namizna aplikacija, ki omogoča prenos modelov, njihovo upravljanje in interakcijo prek klasičnega pogovornega vmesnika. Prednost je preglednost in enostavna uporaba, slabost pa manjša fleksibilnost pri naprednih nastavitvah.

V ozadju številnih od teh orodij deluje llama.cpp, optimizirana implementacija izvajanja modelov, ki omogoča učinkovito rabo procesorjev in različnih arhitektur. Čeprav povprečni uporabnik z njo neposredno ne dela, predstavlja temelj lokalne LLM infrastrukture.

Za napredne scenarije se uporabljajo tudi orodja, ki izpostavijo lokalni model prek API-ja, kar omogoča integracijo v aplikacije, razvojna okolja ali interne sisteme.

Kako do lokalnega jezikovnega modela z Ollama?

Ollama je ena najpreprostejših poti do delujočega lokalnega jezikovnega modela.

V prvem koraku uporabnik namesti program Ollama za svoj operacijski sistem (deluje na Linuxu, Windowsu in Macu).

Če ste na Linuxu, uporabite ukaz v terminalu:

curl -fsSL https://ollama.com/install.sh | sh

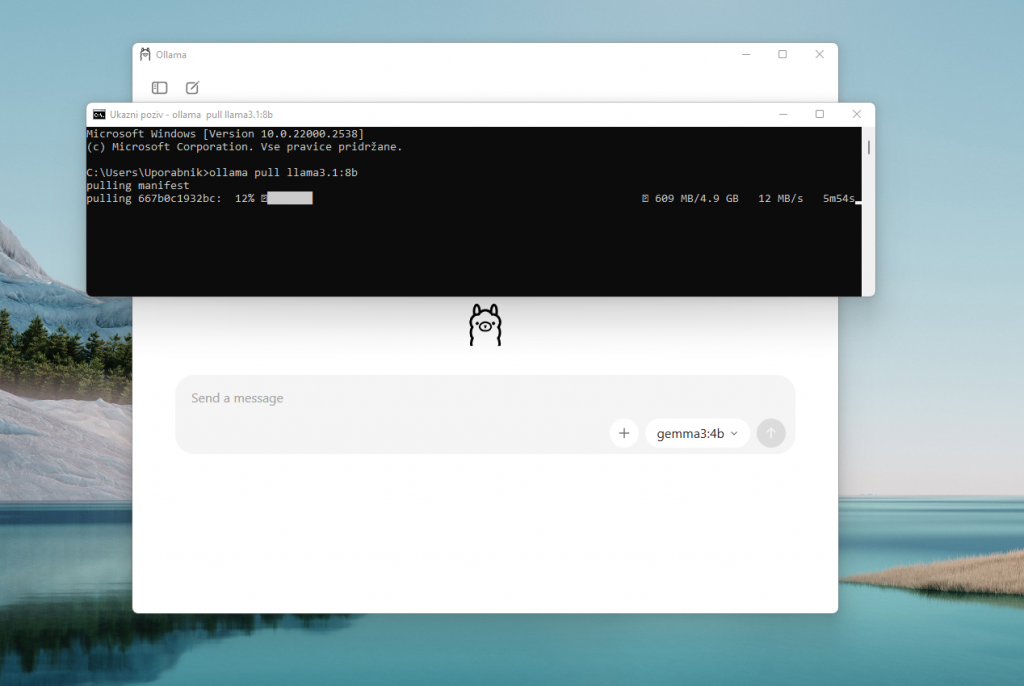

Če ste na Windowsu ali Macu, si lahko prenesete namestitveno datoteko, po namestitvi boste program uporabljali preko pogovornega okna. Ollama vam takoj omogoča, da iz spustnega menija sami izberete (in prenesete) željeni jezikovni model (GPT, Minimax, Qwen, DeepSeek …), lahko pa tudi sami dodate nove modele, vendar s pomočjo ukaznega poziva.

Ob prvem zagonu se model prenese na lokalni disk, kar lahko traja nekaj časa. Če bi želeli na primer naložiti model llama3, vpišite:

ollama pull llama3.1:8b

Seznam vseh modelov vas čaka tukaj.

Po prenosu se model zažene z enostavnim ukazom (na primer ollama run llama3.1:8b), ki odpre interaktivno sejo. V tej fazi se model naloži v pomnilnik in je pripravljen na sprejem pozivov. Priporočljivo je, da uporabnik najprej preizkusi preprost poziv, s katerim preveri stabilnost delovanja.

Za izhod iz seje lahko uporabite bližnjico Ctrl +D ali ukaz /bye.

Ko osnovno program deluje, je mogoče model uporabljati kot interaktivnega sogovornika ali ga povezati z drugimi orodji. Ollama omogoča tudi, da se model izpostavi kot lokalna storitev, do katere lahko dostopajo druge aplikacije. To je posebej uporabno za razvijalce, ki želijo lokalni LLM vključiti v razvojno okolje ali avtomatizirane procese.

Za boljše delovanje lahko uporabnik prilagodi izbiro modela, uporabi bolj agresivno kvantizacijo ali zmanjša velikost konteksta. Vse spremembe je mogoče izvajati postopno, brez ponovne namestitve celotnega sistema.

Če boste naleteli na težavo, imate na Redditu podskupino, kjer boste našli kopico vodičev in tudi dodatno prilagojene jezikovne modele.

Ni šprint, ampak maraton

Vzemite si čas in ne pričakujte enakih rezultatov, kot ste jih vajeni pri že uveljavljenih UI storitvah.

Prijavi napako v članku