智能手机摄像头如何工作?

“你的手机有什么处理器?它有多少空间?多少 RAM?”这就是我们过去比较手机的方式,但现在更常见的问题是:“你手机的摄像头有多好?在测试手机的时候,大家,包括测试人员,包括我们编辑部,最关注的就是摄像头,然后才是手机的整体性能。”由于相机存在很多未知因素和大量技术术语(屏幕、传感器、镜头、焦点...),因此可能是时候澄清一些关于它们工作原理的迷雾了。

一切都围绕着光

令人惊讶(或不惊讶)的是,我们可以在相机和我们的眼睛之间做出如此多的相似之处。在黑暗的房间里,眼睛和相机都是盲目的。为了记录图像,我们需要光。但光线常常会向各个方向散射。我们的眼睛有晶状体,可以将光线引导到视网膜上。甚至我们手机上的摄像头也有捕捉和记录光线信息的镜头。

光也会损害摄影,这对于使用胶片的模拟相机来说最为明显。 (太)长时间暴露在光线下会破坏胶片的内容。光圈的发明解决了这个难题。在模拟相机中,快门是一种物理机制,可以快速打开和关闭以控制到达胶片的光量。眼睑也有类似的功能。

手机上没有物理快门,但拍照时您确实会听到独特的“咔哒”声。这只是一个声音效果。将手机调至静音模式,声音就会消失。手机上的摄像头不是物理快门,而是使用具有相同功能的电子快门,但它通过算法而不是物理运动来完成所有操作。某些智能手机(例如华为 Mate 50 Pro)的摄像头具有可在预设位置之间移动的物理光圈。

这部电影还没有被遗忘。它至今仍在业余爱好者、专业摄影师甚至电影行业中使用。在其他地方,它已被传感器取代。

为什么手机的镜头不同?

您可能见过一位专业摄影师根据他面前的场景更换相机上的镜头。手机在技术上可以做到这一点,正如小米通过小米 12S Ultra 概念手机所展示的那样,但它非常不切实际,并且出现了新的障碍,例如耐用性问题、防水性、高价格等。因此,制造商提出了几种不同的相机作为解决方案 - 每个相机都有自己的特定镜头,可以根据需要在相机应用程序中轻松切换。如今,大多数手机摄像头都是这样工作的。

如果您看一下手机背面,您会发现有两个、三个甚至四个镜头,其中一个位于前面的显示屏上。每一个都提供了不同的视角、深度和自己独特的功能。可以理解的是,主镜头始终存在。超广角摄像头也或多或少是手机上的一个常量。在低端手机中,我们经常会看到微距相机,而高端手机则有长焦镜头和潜望式长焦镜头,例如三星 Galaxy S23 Ultra。

镜头的作用是什么?

光圈、镜头和图像传感器密切相关。光圈是您可以在相机镜头上实际看到的开口。如前所述,光圈控制到达镜头和传感器的光线量。一般来说,光圈越大越好,因为这意味着相机可以使用更多的光线信息。然而,这并不一定是照片质量的最佳指标。

如果您查看手机的规格,您会注意到相机的评级为“f”。这些度数是焦距与光圈物理直径的比率。该数字越小,光圈越宽。例如vivo X90 Pro拥有23mm焦距的f/1.8主镜头、sf/1.6(50mm)长焦镜头等。

您将很难将手机摄像头的性能与焦距进行比较。焦距极其重要,但对于创造不同的美学和视觉效果。较短的焦距旨在获得广角视角 - 附近的物体看起来更大。例如,较长的焦距可以拍摄出比例更匀称且中性的照片。

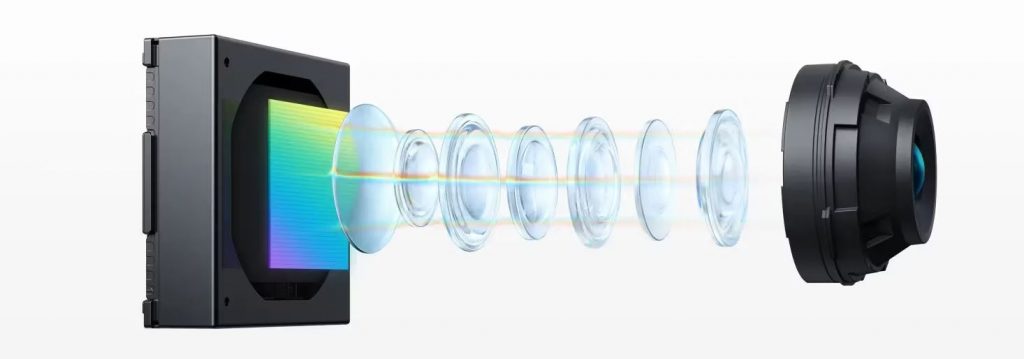

当光线进入相机模块时,镜头会收集来自镜头的入射光并将其引导到传感器上。智能手机摄像头由许多称为元件的塑料镜头组成。由于光的性质,不同波长的光(颜色)在通过透镜时会以不同的角度折射(弯曲)。这意味着场景中的颜色会不对齐地投影到相机传感器上。相机需要多个镜头才能将清晰的图像传输到传感器,而不会出现未对准和其他影响等不规则现象。

智能手机相机的对焦是如何工作的?

具有讽刺意味的是,对焦并不是用户的焦点,因为这通常是由相机本身控制的。在一定程度上,可以手动调整焦点(取决于手机),但在大多数情况下,软件可以很好地完成这项工作,无需手动干预。手机摄像头使用专用传感器和/或附加硬件(例如激光测距仪)进行对焦。

软件自动对焦使用来自图像传感器的数据来确定图像是否对焦并调整镜头进行补偿。被动自动对焦的常用技术是基于检测图像的对比度并调整焦点直至其达到最大值。这种方法完全基于软件,是最便宜的选择。然而,该过程速度较慢,并且在弱光条件下效果不佳。

较新的手机使用相位检测自动对焦 (PDAF),速度更快、更准确。查看最新 iPhone 15 Pro Max 的规格,您会注意到相机上的 PDAF 标签。后者确保相同数量的光到达图像传感器上两个靠近放置的传感器。经典的 PDAF 系统依靠图像传感器上的这些专用感光点来测量来自镜头左侧或右侧的光线。如果右侧图像点与左侧点的光强度相同,则图像处于对焦状态。如果强度不同,系统可以计算出需要补偿多少才能获得清晰的图像,这比依赖对比度检测的系统要快得多。

较旧的 PDAF 系统仅使用所有图像站点的百分之几,而较新的系统(例如 Galaxy S23 Ultra)则使用全部 100%。除了左右像点之外,上、下像点也用于对焦。

iPhone 长期以来一直配备专用 LiDAR 传感器,可改善对焦、深度感知、夜间成像,并且非常适合增强现实 (AR) 应用。

什么是图像传感器?

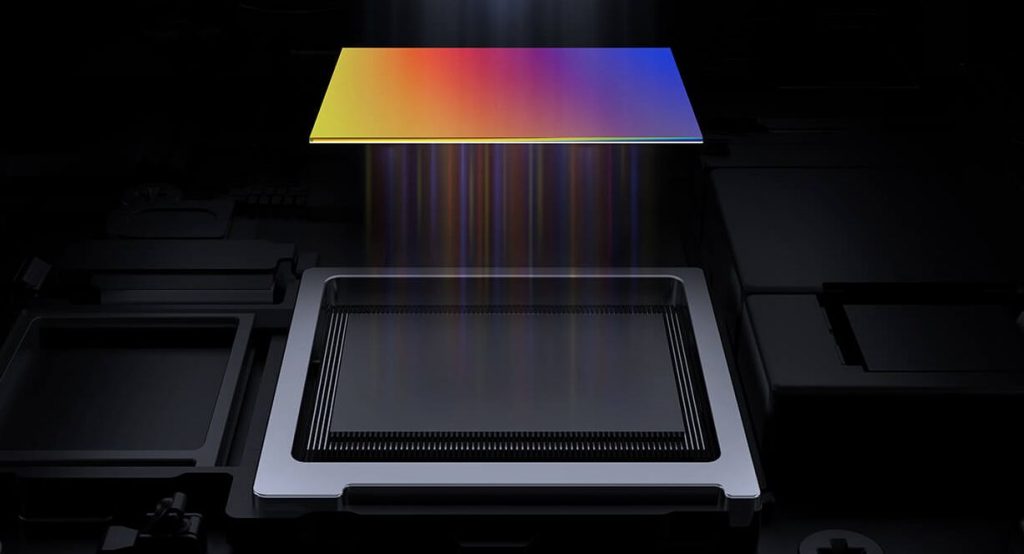

传感器基本上只是一个硅晶圆,这取决于很多因素。传感器接收光并将其转换为电信号。传感器可以有几百万像素。你怎么能发现这一点?如果您看到 100 或 200 MP 相机,则意味着相关传感器具有 100 甚至 200 兆像素。如果来自镜头的光没有到达图像点,传感器会将该图像点记录为黑色。如果图像点接收到大量光线,传感器会将其记录为白色。传感器可以记录的灰度称为位深度。

大多数手机具有 8 位深度,但有些手机具有 10 位深度。相比之下,8 位深度意味着相机可以为用于混合色谱(红色、绿色和蓝色)的每个原色通道捕获 256 种色调。即红、绿、蓝 256 种色调。总共有 1670 万种可能的色调。 10 位相机可以捕捉超过 10 亿种色调。

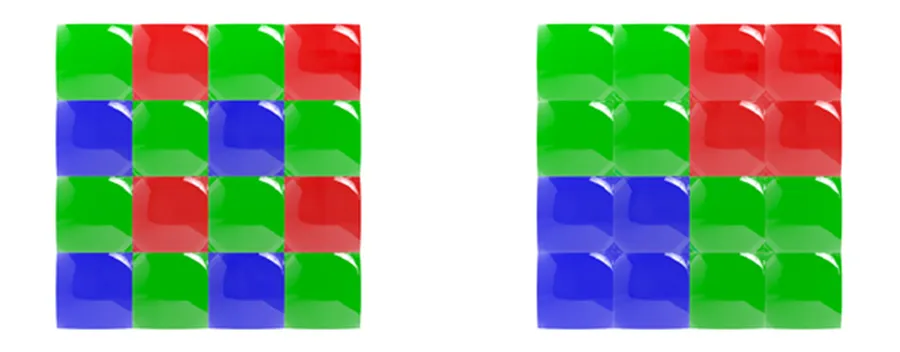

相机如何拍摄彩色照片?每个图像点都有一个滤色器,仅允许某些颜色通过。除了极少数例外,例如华为手机使用RYYB(黄色而不是绿色滤镜),最常用的是拜耳滤色器阵列,它将图像点的每个正方形(2×2)分为红色、蓝色和两个绿色过滤器(RGGB)。

通常,运行一组拜耳滤镜的相机会将所有这些颜色数据汇总为一个值,但像素合并不会执行此操作。制造商需要一种方法来单独收集每种颜色。

为此,他们设计了所谓的四拜耳阵列,其中每组像素 (2×2) 被分配一种颜色。然后将其中的四个组合在一起 - 非常类似于原始的拜耳滤光片组:2x 绿色、1x 蓝色、1x 红色。

新套件不仅允许智能手机制造商在组合像素的过程中保留颜色数据,还允许他们引入其他创新功能,例如 HDR 模式。

让我们回到传感器。对于传感器,有必要注意它们的尺寸和像素本身的尺寸。更大的传感器可以拍摄更好的照片,因为它们具有更多的图像区域,也更大。最近,智能手机及其相机已进入 1 英寸世界。例如,小米13 Pro和vivo X90 Pro是首批采用1英寸传感器的手机。

像素以微米 (μm) 为单位进行测量。较大的像素可以吸收更多的光线,有利于夜间摄影。如果您的手机像素比其他手机小,请不要担心。除了夜间拍摄之外,它仍然能够提供不错的效果。即使是最好的三星手机也难以应对较小的像素。 Galaxy S23 Ultra 配备了 200 MP 传感器,像素为 0.6 µm,而 iPhone 15 Pro Max 则配备了 48 MP 传感器,像素为 1.22 µm。因此,制造商开始使用像素合并技术。 Galaxy S23 Ultra 将 16 个像素合二为一,拍摄的照片最终分辨率为 12 MP。

光学和电子稳定

稳定性对于拍摄优质照片和视频也很重要:光学或电子。

OIS 是一种硬件解决方案,使用微机电系统 (MEMS) 陀螺仪来检测运动并相应地调整相机系统。例如:如果您拿着智能手机并且手稍微向左移动,OIS 系统会检测到这一情况并将相机稍微向右移动。这在夜间摄影中尤其重要,因为相机需要很长时间来捕捉光线,在此期间振动会影响照片的质量。

电子图像稳定 (EIS) 依靠手机的加速计来检测运动。它不是移动相机的部件,而是移动图像或灯光的帧。由于曝光是根据图像内容而不是图像传感器帧来对齐的,因此最终图像或视频剪辑的分辨率会降低。

该软件有什么作用?

图像传感器将光转换为电信号后,图像信号处理器 (ISP) 的工作就是将这些数字转换为图像。电信号中的数据本质上是黑白图像。 ISP 必须首先返回基于一组滤色器(拜耳或其他)的颜色数据。这会创建一个图像,但像素具有不同的红色、绿色或蓝色强度。接下来是颜色重建,其中 ISP 根据相邻像素的颜色更改像素的颜色。例如,如果某个区域中有很多绿色和红色像素,而蓝色像素很少,则颜色重建算法会将它们转换为黄色。

色彩重建完成后,ISP 还具有去噪和锐化算法。每部手机都有自己的特定算法来生成最终照片。

下次您拿起手机,打开相机并拍照时,您就会知道那段时间背景中发生了什么。您对智能手表或其传感器的工作原理感兴趣吗?