Apple、Nvidia 和 Anthropic 使用 YouTube 视频来训练人工智能

科技公司正在使用有争议的策略来满足其数据需求旺盛的人工智能(AI)模型。来自书籍、网站、照片和社交媒体帖子的数据经常在创作者不知情的情况下被使用。

人工智能公司对数据非常保密

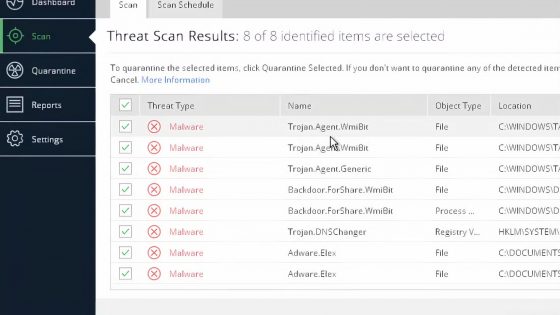

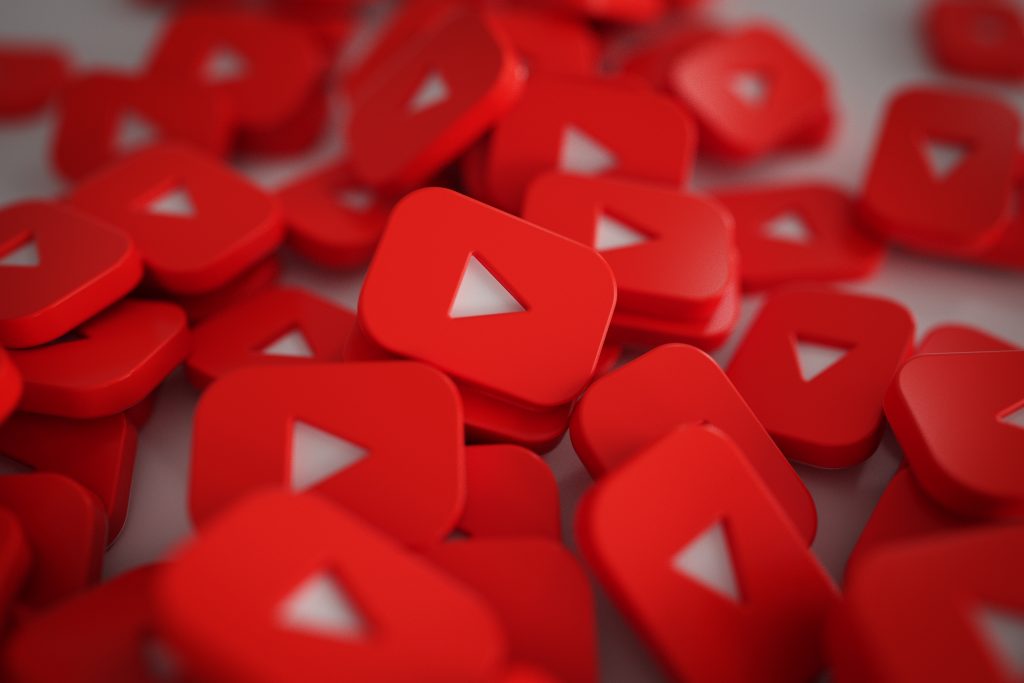

然而,训练人工智能模型的公司通常对其数据来源非常保密。我们之前已经多次指出过这一点,但现在非营利新闻组织 Proof News 的一项调查显示,世界上一些人工智能领域的主要参与者一直在使用 YouTube 上发布的数千个视频中的培训材料。尽管 YouTube 规定禁止未经许可从该平台收集材料,但这些公司还是这样做了。

据称,许多来自硅谷的公司使用从上述平台上的 48,000 多个频道获得的 173,000 多个视频的字幕(YouTube 字幕)来收集数据。据称这些公司包括 Anthropic、Nvidia、Apple 和 Salesforce。

模型也应该从阴谋论中学习

名为 YouTube Subtitles 的数据集包含来自可汗学院、麻省理工学院和哈佛大学等教育频道的视频抄本。他们还使用《华尔街日报》、NPR 和 BBC 等新闻媒体。据称,《斯蒂芬·科尔伯特深夜秀》、《约翰·奥利弗上周今夜秀》和《吉米金梅尔现场秀》等视频均被提取数据。但他们也从 YouTube 巨星那里找到了素材,包括 MrBeast、Marques Brownlee、Jacksepticeye 和 PewDiePie 等创作者。这些创作者拥有超过 1000 万粉丝,例如 MrBeast 甚至拥有 3 亿粉丝。

除此之外,问题还可能在于人工智能还从视频中提取数据,例如宣扬地球是平坦表面等阴谋论的视频。

“没有人来找我问,‘我们可以使用这个吗?’”大卫·帕克曼秀 (The David Pakman Show) 的主持人大卫·帕克曼 (David Pakman) 说道,该频道拥有超过 200 万订阅者和超过 20 亿的观看次数。他的近 160 个视频已用于 AI 训练。其全职制作由四名员工创作,他们发布播客、视频,这些内容也在 TikTok 和其他平台上发布。帕克曼说,如果人工智能公司获得报酬来做这件事,他们应该因使用这些数据而获得补偿。他强调,一些媒体公司最近签订了支付人工智能培训作品使用费用的协议。 “这就是我的谋生之道,我投入时间、资源、金钱和员工的时间来创作内容,”他说。

流媒体服务 Nebula 总监戴夫·威斯库斯 (Dave Wiskus) 表示:“这真是太划算了。”他表示,未经创作者同意而使用创作者的作品是不尊重的行为。特别是因为工作室将来可能能够使用“生成人工智能来取代当今创作者的视频”。 “他们会利用这种学习来剥削和伤害艺术家吗?肯定会的,”威斯库斯确信道。

这一切从哪里开始?

据说该数据集是非营利组织 EleutherAI 发布的名为 Pile 的汇编的一部分。其中不仅包括来自 YouTube 的材料,还包括来自欧洲议会、英语维基百科的材料,以及作为联邦调查的一部分而发布的安然员工的大量电子邮件。

大多数 Pile 数据集都可以在互联网上获取,并且向任何拥有足够空间和计算能力的人开放来访问它们。 “大型科技”之外的学者和其他开发人员使用了该数据集,但他们并不是唯一的人。

苹果、英伟达和 Salesforce 等公司在其公告中描述,他们使用 Pile 来训练人工智能。文件显示,Pile 还使用 Apple 来训练 OpenELM,这是 4 月份发布的一个备受瞩目的模型,几周前该公司就透露将为 iPhone 和 MacBook 添加新的 AI 功能。

Anthropic 也是如此,亚马逊向领先的人工智能开发商 Anthropic 投资了 40 亿美元,并正在推动其对“人工智能安全”的关注。

然而,令人担忧的不仅仅是上述阴谋论。 Pile 还包含大量脏话,据说对性别、某些宗教团体和种族有偏见。

YouTube 数据集的创建者 EleutherAI 的代表尚未回应对 Proof News 调查结果发表评论的请求。该公司网站称,他们的总体目标是减少人工智能发展的障碍,即使是在代表“科技巨头”的公司之外。

YouTube 字幕不包含视频剪辑,而是由视频字幕的纯文本组成,通常附有日语、德语和阿拉伯语等语言的翻译。

YouTube 是数据金矿

开发人工智能的公司正在相互竞争,看看哪一家拥有更好的人工智能模型。今年早些时候,《纽约时报》报道称,拥有 YouTube 的谷歌正在视频上训练其模型。谷歌发言人表示,这些片段是根据与在该平台上发布的创作者签订的合同使用的。

在同一项调查中,媒体报道称这些视频据称是 Open AI 公司未经授权使用的,但该公司既没有否认也没有证实这一点。据一些报道称,这些数据应该用于训练其人工智能模型Sora,该模型可以根据语言提示创建视频。

YouTube 字幕和类似的解决方案是数据的金矿,因为它们对于训练模仿人类语音或对话的模型有很大帮助。当然,人工智能可以从 YouTube 上最大的视频集合中学到最多的东西。

Proof News 希望得到这篇报道中的频道所有者的反应。那些设法掌握它们的人并不知道他们的数据正在被用来训练人工智能。令人惊讶的是节目《Crash Course》和《SciShow》的制作人,它们是汉克·格林和约翰·格林兄弟视频教育帝国的支柱。制作公司 Complexly 的首席执行官朱莉·沃尔什·史密斯 (Julie Walsh Smith) 在一份声明中表示:“我们很失望地发现,我们精心制作的教育内容在未经我们同意的情况下被以这种方式使用。”

YouTube 的字幕只是一系列用于训练人工智能的数据盗窃案例之一,给创意产业带来了问题。当他们使用超过 180,000 本书(Books3)来训练人工智能时,也发生了类似的事情。再次使用 Pile 数据集。当时,许多作者起诉人工智能公司未经授权使用其作品并涉嫌侵犯版权。

预计未来还会有更多类似纠纷

大多数诉讼仍处于早期阶段,因此有关许可和潜在处罚的问题仍然悬而未决。 Pile 数据库已从官方下载网站删除,但仍可在文件共享服务上使用。

开发人工智能的公司以某种方式捍卫合理使用,而不称其为一个地方,另一方面,创造者不同意这一点,并期望补偿或某种形式的使用补偿,特别是如果我们以这样的方式看待未来:人工智能可能会夺走他们的部分业务。

也正是因为以上种种,才让创作者们处于相当大的不确定性之中。 YouTuber 将在视频中添加免责声明作为他们的全职工作。他们担心人工智能迟早能够创建与他们自己制作的内容非常相似的内容,甚至能够创建完美的模仿,这只是时间问题。

《大卫·帕克曼秀》(The David Pakman Show) 的创作者帕克曼 (Pakman) 最近在浏览 TikTok 时体验到了人工智能的力量。他偶然看到一段标有美国政治评论员塔克·卡尔森录音的视频,但当他看到这个视频时,他哑口无言。这听起来像卡尔森,但他准确地认出了他自己在 YouTube 节目中重复说过的话。更让他担心的是,他发现该剪辑下的所有评论中只有一条认为这是假的,这是卡尔森朗读帕克曼剧本的声音克隆。

帕克曼相信,这将是一个大问题,因为你可以对任何人的声音做同样的事情。