Come funzionano le fotocamere degli smartphone?

"Che processore ha il tuo telefono? Quanto spazio ha? Quanta RAM?" Questo è il modo in cui confrontavamo i telefoni, ma oggi le domande più comuni sono: "Quanto sono buone le fotocamere del tuo telefono? Quanto bene scatta foto e video di notte?" Quando testano i telefoni, tutti, compresi i tester, compresi noi della redazione, prestano la massima attenzione alle fotocamere e solo allora alle prestazioni generali del telefono. Dato che ci sono parecchie incognite riguardo alle fotocamere e molta terminologia tecnica (schermo, sensori, obiettivi, messa a fuoco...), potrebbe essere il momento di chiarire un po' la nebbia sul loro funzionamento.

Tutto ruota attorno alla luce

È sorprendente (o no) quanti paralleli possiamo fare tra la macchina fotografica e il nostro occhio. Nelle stanze buie, gli occhi e le telecamere sono ciechi. Per registrare un'immagine, abbiamo bisogno di luce. Ma la luce è spesso diffusa in tutte le direzioni. I nostri occhi sono dotati di lenti che dirigono la luce sulla retina. Anche le fotocamere dei nostri telefoni sono dotate di obiettivi che catturano e registrano le informazioni sulla luce.

La luce può anche danneggiare la fotografia, il che è più evidente con le fotocamere analogiche che utilizzano pellicole fotografiche. Un'esposizione (troppo) lunga alla luce può distruggere il contenuto della pellicola. L'invenzione dell'apertura ha risolto questo enigma. Nelle fotocamere analogiche, l'otturatore è un meccanismo fisico che si apre e si chiude rapidamente per controllare la quantità di luce che raggiunge la pellicola. Le palpebre hanno una funzione simile.

Sui telefoni non esiste un otturatore fisico, sebbene sia possibile udire quel caratteristico "clic" quando si scatta una foto. Si tratta solo di un effetto sonoro. Mettete il telefono in modalità silenziosa e il suono scomparirà. Invece di un otturatore fisico, le fotocamere dei telefoni utilizzano un otturatore elettronico, che svolge la stessa funzione, ma tramite algoritmi anziché tramite movimento fisico. Alcuni smartphone, come Huawei Mate 50 La versione Pro, invece, è dotata di una fotocamera con un otturatore fisico che può essere spostato tra posizioni preimpostate.

Il film non è stato ancora dimenticato. È ancora in uso tra gli hobbisti, i fotografi professionisti e persino nell'industria cinematografica. Altrove è stato sostituito dai sensori.

Perché i telefoni cellulari hanno lenti diverse?

Probabilmente hai visto un fotografo professionista cambiare l'obiettivo della sua macchina fotografica a seconda della scena che si trova di fronte. Gli smartphone sono tecnicamente in grado di farlo, come ha dimostrato Xiaomi con il suo concept phone. Xiaomi 12S Ultra Concept, ma è estremamente poco pratico e, inoltre, sorgono nuovi ostacoli, come problemi di durata, resistenza all'acqua, prezzo elevato e simili. I produttori hanno quindi proposto diverse fotocamere come soluzione, ciascuna con il proprio obiettivo specifico, facilmente intercambiabile all'interno dell'app della fotocamera in base alle esigenze. Oggi, la maggior parte delle fotocamere degli smartphone funziona in questo modo.

Se guardate il retro del vostro telefono, noterete due, tre o addirittura quattro obiettivi, e uno sullo schermo frontale. Ognuno offre un diverso angolo di visione, profondità e caratteristiche uniche. L'obiettivo principale è comprensibilmente sempre presente. Una fotocamera ultra-grandangolare è anche più o meno uno standard sui telefoni cellulari. Nei modelli di fascia bassa, troviamo spesso una fotocamera macro, mentre nei telefoni premium troviamo un teleobiettivo e un teleobiettivo periscopico, come quello sul... Samsung Galaxy S23 Ultra.

Qual è la funzione della lente?

Apertura, obiettivo e sensore di immagine sono strettamente correlati. L'apertura è l'apertura che puoi vedere fisicamente sull'obiettivo della fotocamera. Come accennato, l'apertura controlla la quantità di luce che raggiunge l'obiettivo e il sensore. Come regola generale, un'apertura maggiore è migliore perché significa che la fotocamera può utilizzare più informazioni sulla luce. Tuttavia, questo non è necessariamente il miglior indicatore della qualità della foto.

Se guardate le specifiche del vostro telefono, noterete la notazione "f" sulle fotocamere. Questi stop rappresentano il rapporto tra la lunghezza focale e il diametro fisico dell'apertura. Più piccolo è questo numero, più ampia è l'apertura. Ad esempio, vivoX90 Pro ha un obiettivo principale con un'apertura di f/1.8 e una lunghezza focale di 23 mm, un teleobiettivo di f/1.6 (50 mm) e così via.

Avrai difficoltà a confrontare le prestazioni delle fotocamere del telefono con la lunghezza focale. La lunghezza focale è estremamente importante, ma aiuta a creare estetiche ed effetti visivi diversi. Una lunghezza focale più corta è destinata ad una prospettiva grandangolare: gli oggetti vicini appaiono più grandi. Una lunghezza focale maggiore, ad esempio, crea una foto più proporzionale e neutra.

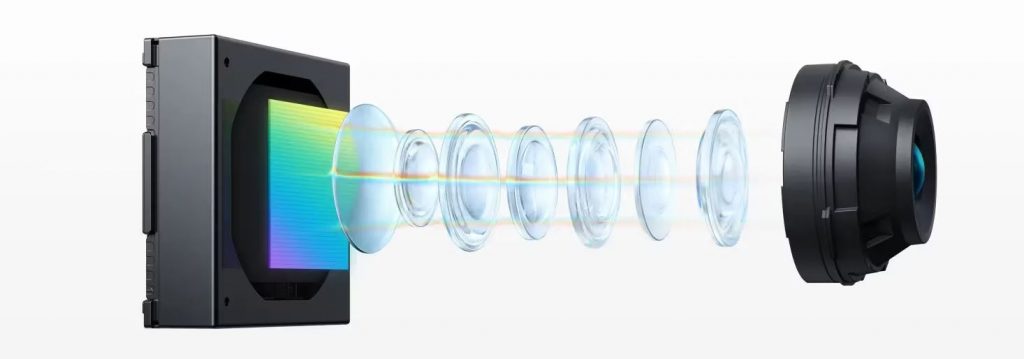

Quando la luce entra nel modulo della fotocamera, l'obiettivo raccoglie la luce in entrata dallo scatto e la dirige sul sensore. Le fotocamere degli smartphone sono costituite da numerose lenti in plastica chiamate elementi. A causa della natura della luce, diverse lunghezze d'onda della luce (colori) vengono rifratte (piegate) ad angoli diversi quando passano attraverso una lente. Ciò significa che i colori della scena vengono proiettati sul sensore della fotocamera fuori allineamento. Le fotocamere necessitano di più obiettivi per trasmettere un'immagine chiara al sensore senza possibili irregolarità come disallineamento e altri effetti.

Come funziona la messa a fuoco sulle fotocamere degli smartphone?

Per ironia della sorte, la messa a fuoco non è quella dell'utente perché di solito è controllata dalle fotocamere stesse. In una certa misura, la messa a fuoco può essere regolata manualmente (a seconda del telefono), ma nella maggior parte dei casi il software fa il lavoro così bene che l'intervento manuale non è necessario. Le fotocamere dei cellulari utilizzano un sensore dedicato e/o hardware aggiuntivo come un telemetro laser per mettere a fuoco.

La messa a fuoco automatica del software utilizza i dati del sensore di immagine per determinare se l'immagine è a fuoco e regola le lenti per compensare. La tecnica abituale dell'autofocus passivo si basa sul rilevamento del contrasto dell'immagine e sulla regolazione della messa a fuoco fino al suo massimo. Questo metodo è interamente basato su software, il che lo rende l’opzione più economica. Tuttavia, il processo è più lento e non funziona altrettanto bene in condizioni di scarsa illuminazione.

I telefoni più recenti utilizzano l'autofocus a rilevamento di fase (PDAF), più veloce e preciso. Vai alle specifiche più recenti iPhone 15 Pro Max e sulle fotocamere noterete la dicitura PDAF. Quest'ultima garantisce che la stessa quantità di luce raggiunga due sensori ravvicinati sul sensore di immagine. I sistemi PDAF classici si basano su fotositi dedicati sul sensore di immagine per misurare la luce proveniente dal lato sinistro o destro dell'obiettivo. Se i fotositi a destra registrano la stessa intensità di luce di quelli a sinistra, l'immagine è a fuoco. Se l'intensità non è la stessa, il sistema può calcolare la compensazione necessaria per ottenere un'immagine nitida, molto più velocemente rispetto ai sistemi che si basano sul rilevamento del contrasto.

I sistemi PDAF più vecchi utilizzano solo una piccola percentuale di tutti i siti di immagini, mentre quelli più recenti, come il Galaxy S23 Ultra, ne utilizzano tutto il 100%. Oltre ai punti immagine sinistro e destro, per la messa a fuoco vengono utilizzati anche i punti immagine superiore e inferiore.

Gli iPhone dispongono da tempo di un sensore LiDAR dedicato che migliora la messa a fuoco, la percezione della profondità, l'imaging notturno ed è utile per le applicazioni di realtà aumentata (AR).

Cos'è un sensore di immagine?

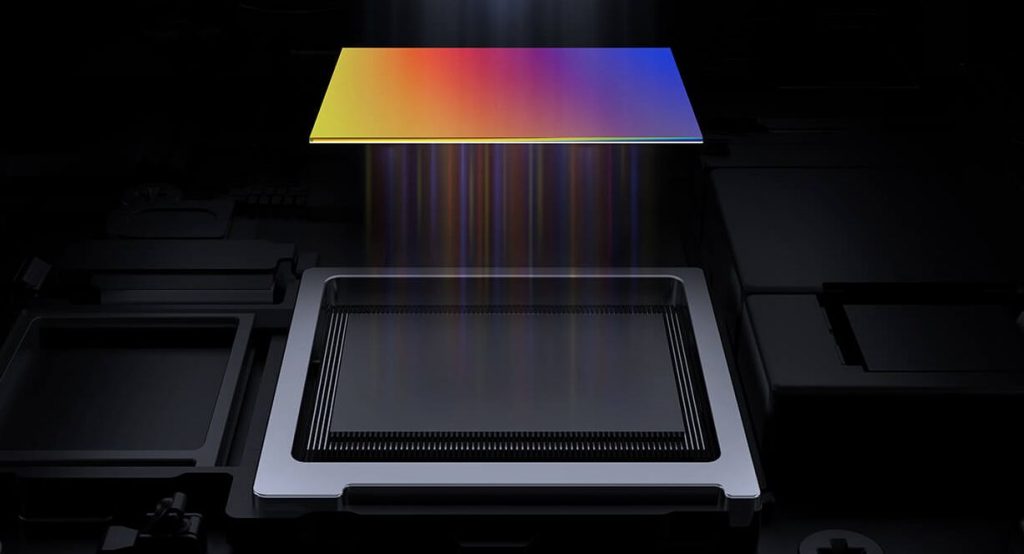

Il sensore è fondamentalmente solo un wafer di silicio, da cui dipende molto. Il sensore riceve la luce e la converte in segnali elettrici. Un sensore può avere diversi milioni di pixel. Come puoi scoprirlo? Se vedi una fotocamera da 100 o 200 MP, significa che il sensore in questione ha 100 o addirittura 200 megapixel. Se la luce dell'obiettivo non raggiunge il punto dell'immagine, il sensore registra questo punto dell'immagine come nero. Se il punto dell'immagine riceve molta luce, il sensore lo registra come bianco. Le sfumature di grigio che il sensore può registrare sono chiamate profondità di bit.

La maggior parte dei telefoni ha una profondità di 8 bit, ma alcuni hanno una profondità di 10 bit. In confronto, la profondità a 8 bit significa che la fotocamera può catturare 256 tonalità per ciascun canale di colore primario utilizzato per miscelare lo spettro dei colori (rosso, verde e blu). Sono 256 sfumature di rosso, verde e blu. In totale si tratta di 16,7 milioni di possibili sfumature di colore. Le fotocamere a 10 bit possono catturare più di un miliardo di sfumature.

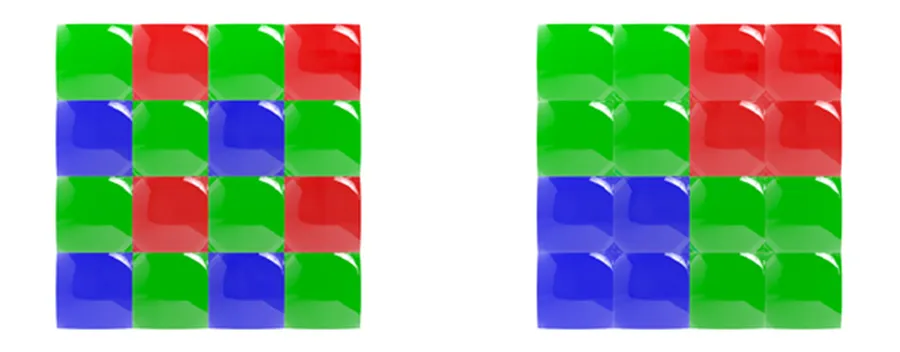

Come fa una fotocamera a catturare una foto a colori? Ogni pixel ha un filtro colore che lascia passare solo determinati colori. Con rare eccezioni, come i telefoni Huawei che utilizzano filtri RYYB (giallo anziché verde), la matrice di filtri colore più comunemente utilizzata è la matrice Bayer, che divide ogni quadrato (2x2) del pixel in filtri rosso, blu e due verdi (RGGB).

Normalmente, una fotocamera che esegue una serie di filtri Bayer sommerà tutti questi dati di colore in un unico valore, ma il pixel binning non lo fa. I produttori avevano bisogno di un modo per raccogliere ciascun colore individualmente.

A tal fine, hanno progettato un cosiddetto array quad-Bayer, in cui a ogni gruppo di pixel (2x2) viene assegnato un singolo colore. Quattro di questi vengono poi combinati insieme, in modo simile all'array di filtri Bayer originale: 2x verde, 1x blu, 1x rosso.

Il nuovo set non solo consente ai produttori di smartphone di preservare i dati cromatici nel processo di combinazione dei pixel, ma ha anche permesso loro di introdurre altre funzionalità innovative come la modalità HDR.

Torniamo ai sensori. Quando si parla di sensori, bisogna prestare attenzione alle loro dimensioni e a quelle dei pixel stessi. I sensori più grandi possono catturare foto migliori perché hanno più pixel, che sono anche più grandi. Di recente, gli smartphone e le loro fotocamere sono entrati nel mondo da 1 pollice. Xiaomi 13Pro Ad esempio, il vivo X90 Pro è tra i primi a integrare sensori da 1 pollice.

I pixel sono misurati in micrometri (μm). I pixel più grandi possono assorbire più luce, il che è positivo per la fotografia notturna. Non preoccuparti se il tuo telefono ha pixel più piccoli rispetto ad altri telefoni. Al di fuori della fotografia notturna, sarà comunque in grado di fornire buoni risultati. Anche i migliori telefoni Samsung hanno problemi con i pixel più piccoli. Il Galaxy S23 Ultra ha un sensore da 200 MP con pixel da 0,6 µm, mentre l'iPhone 15 Pro Max ha un sensore da 48 MP con pixel da 1,22 µm. I produttori hanno quindi iniziato a utilizzare la tecnologia di pixel binning. Il Galaxy S23 Ultra combina 16 pixel in uno per catturare foto con una risoluzione finale di 12 MP.

Stabilizzazione ottica ed elettronica

Anche la stabilizzazione è importante per catturare foto e video di buona qualità: ottica o elettronica.

OIS è una soluzione hardware che utilizza un giroscopio del sistema microelettromeccanico (MEMS) per rilevare il movimento e regolare di conseguenza il sistema di telecamere. Esempio: se hai in mano uno smartphone e la tua mano si sposta leggermente verso sinistra, il sistema OIS lo rileverà e sposterà leggermente la fotocamera verso destra. Ciò è particolarmente importante nella fotografia notturna, quando la fotocamera impiega molto tempo per catturare la luce, tempo durante il quale le vibrazioni possono influenzare la qualità della foto.

La stabilizzazione elettronica dell'immagine (EIS) si basa sull'accelerometro del telefono per rilevare il movimento. Invece di spostare parti della fotocamera, sposta i fotogrammi dell'immagine o l'illuminazione. Poiché le esposizioni sono allineate in base al contenuto dell'immagine e non al fotogramma del sensore immagine, l'immagine o il video finale hanno una risoluzione ridotta.

Cosa fa il software?

Dopo che il sensore di immagine ha convertito la luce in segnali elettrici, è compito del processore del segnale di immagine (ISP) convertire quei numeri in un'immagine. I dati nei segnali elettrici sono essenzialmente un'immagine in bianco e nero. L'ISP deve prima restituire i dati relativi al colore in base a una serie di filtri colorati (Bayer o qualcos'altro). Questo crea un'immagine, ma i pixel hanno diverse intensità di rosso, verde o blu. Segue la ricostruzione del colore, in cui l'ISP modifica i colori dei pixel in base ai colori dei pixel vicini. Ad esempio, se in una determinata area sono presenti molti pixel verdi e rossi e pochissimi pixel blu, gli algoritmi di ricostruzione del colore li convertono in gialli.

L'ISP dispone anche di algoritmi di riduzione del rumore e di nitidezza dopo aver eseguito la ricostruzione del colore. Ogni telefono ha poi i propri algoritmi specifici per produrre la foto finale.

La prossima volta che prenderai in mano il telefono, accenderai la fotocamera e scatterai una foto, saprai cosa stava succedendo in background in quel momento. Potrebbe interessarti: Come funzionano gli smartwatch? o i loro sensori?