Comment fonctionnent les caméras des smartphones ?

"De quel processeur dispose votre téléphone ? De combien d'espace dispose-t-il ? Combien de RAM ?" C'est ainsi que nous comparions les téléphones, mais aujourd'hui, les questions les plus courantes sont : "Quelle est la qualité des appareils photo de votre téléphone ? Dans quelle mesure prend-il des photos et des vidéos la nuit ? » Lors des tests de téléphones, tout le monde, y compris les testeurs, y compris nous à la rédaction, accorde la plus grande attention aux caméras et ensuite seulement aux performances globales du téléphone. Puisqu'il existe de nombreuses inconnues autour des appareils photo et beaucoup de terminologie technique (écran, capteurs, objectifs, mise au point...), il est peut-être temps de dissiper un peu le brouillard autour de leur fonctionnement.

Tout tourne autour de la lumière

Il est surprenant (ou pas) de voir combien de parallèles nous pouvons faire entre l'appareil photo et notre œil. Dans les pièces sombres, les yeux et les caméras sont aveugles. Pour enregistrer une image, nous avons besoin de lumière. Mais la lumière est souvent diffusée dans toutes les directions. Nos yeux sont dotés de lentilles qui dirigent la lumière sur la rétine. Même les appareils photo de nos téléphones sont dotés d’objectifs qui capturent et enregistrent les informations lumineuses.

La lumière peut également nuire à la photographie, ce qui est particulièrement évident avec les appareils photo analogiques utilisant des films photographiques. Une (trop) longue exposition à la lumière peut détruire le contenu du film. L’invention de l’ouverture a résolu cette énigme. Dans les appareils photo analogiques, l'obturateur est un mécanisme physique qui s'ouvre et se ferme rapidement pour contrôler la quantité de lumière qui atteint le film. Les paupières ont une fonction similaire.

Les téléphones ne possèdent pas d'obturateur physique, mais on entend ce « clic » caractéristique lorsqu'on prend une photo. Il s'agit simplement d'un effet sonore. Mettez votre téléphone en mode silencieux et le son disparaîtra. Au lieu d'obturateurs physiques, les appareils photo des téléphones utilisent un obturateur électronique, qui fonctionne de la même manière, mais grâce à des algorithmes plutôt qu'à des mouvements physiques. Certains smartphones, comme Huawei Mate 50 Pro, en revanche, dispose d'un appareil photo avec un obturateur physique qui peut être déplacé entre des positions prédéfinies.

Le film n'est pas encore oublié. Il est toujours utilisé par les amateurs, les photographes professionnels et même dans l'industrie cinématographique. Ailleurs, il a été remplacé par des capteurs.

Pourquoi les téléphones portables ont-ils des objectifs différents ?

Vous avez probablement déjà vu un photographe professionnel changer d'objectif en fonction de la scène. Les téléphones en sont techniquement capables, comme l'a prouvé Xiaomi avec son concept de téléphone. Concept Xiaomi 12S Ultra, mais c'est extrêmement peu pratique, et de nouveaux obstacles apparaissent, tels que des problèmes de durabilité, d'étanchéité, de prix élevé, etc. Les fabricants ont donc proposé plusieurs appareils photo différents, chacun doté de son propre objectif, facilement interchangeable dans l'application appareil photo selon les besoins. Aujourd'hui, la plupart des appareils photo des téléphones fonctionnent de cette manière.

Si vous regardez à l'arrière de votre téléphone, vous remarquerez deux, trois, voire quatre objectifs, et un sur l'écran avant. Chacun offre un angle de vue, une profondeur de champ et des fonctionnalités uniques. L'objectif principal est naturellement toujours présent. Un appareil photo ultra grand-angle est également quasiment la norme sur les téléphones portables. En entrée de gamme, on trouve souvent un appareil photo macro, tandis que les téléphones haut de gamme proposent un téléobjectif et un téléobjectif périscopique, comme celui du Samsung Galaxy S23 Ultra.

Quelle est la fonction de la lentille ?

L'ouverture, l'objectif et le capteur d'image sont étroitement liés. L'ouverture est l'ouverture que vous pouvez physiquement voir sur l'objectif de l'appareil photo. Comme mentionné, l'ouverture contrôle la quantité de lumière qui atteindra l'objectif et le capteur. En règle générale, une ouverture plus grande est préférable car elle signifie que l'appareil photo peut utiliser plus d'informations lumineuses. Cependant, ce n’est pas forcément le meilleur indicateur de la qualité d’une photo.

Si vous consultez les spécifications de votre téléphone, vous remarquerez une notation pour les diaphragmes « f » sur les appareils photo. Ces diaphragmes correspondent au rapport entre la distance focale et le diamètre physique de l'ouverture. Plus ce nombre est petit, plus l'ouverture est grande. Par exemple : vivo X90 Pro il possède un objectif principal avec une ouverture de f/1,8 et une distance focale de 23 mm, un téléobjectif de f/1,6 (50 mm), etc.

Vous aurez du mal à comparer les performances des appareils photo des téléphones avec la distance focale. La distance focale est extrêmement importante, mais pour créer des esthétiques et des effets visuels différents. Une distance focale plus courte est destinée à une perspective grand angle : les objets proches semblent plus grands. Une focale plus longue, par exemple, crée une photo plus proportionnelle et neutre.

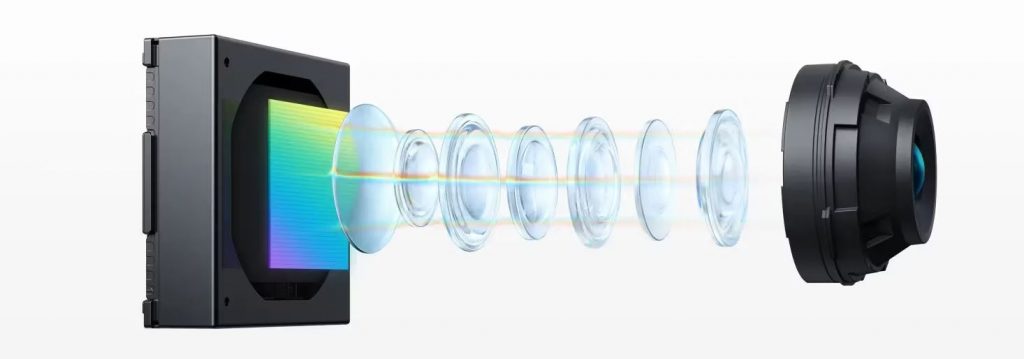

Lorsque la lumière pénètre dans le module de la caméra, l'objectif collecte la lumière entrante de la prise de vue et la dirige vers le capteur. Les appareils photo des smartphones sont constitués de nombreuses lentilles en plastique appelées éléments. En raison de la nature de la lumière, différentes longueurs d’onde de lumière (couleurs) sont réfractées (courbées) sous différents angles lorsqu’elles traversent une lentille. Cela signifie que les couleurs de votre scène sont projetées sur le capteur de la caméra de manière désalignée. Les appareils photo ont besoin de plusieurs objectifs pour transmettre une image claire au capteur sans irrégularités possibles telles qu'un désalignement et d'autres effets.

Comment fonctionne la mise au point sur les appareils photo des smartphones ?

Ironiquement, la mise au point n'est pas celle de l'utilisateur car elle est généralement contrôlée par les caméras elles-mêmes. Dans une certaine mesure, la mise au point peut être ajustée manuellement (en fonction du téléphone), mais dans la plupart des cas, le logiciel fait si bien le travail qu'une intervention manuelle n'est pas nécessaire. Les appareils photo des téléphones portables utilisent un capteur dédié et/ou du matériel supplémentaire tel qu'un télémètre laser pour faire la mise au point.

L'autofocus logiciel utilise les données du capteur d'image pour déterminer si l'image est nette et ajuste les objectifs pour compenser. La technique habituelle de l'autofocus passif repose sur la détection du contraste de l'image et l'ajustement de la mise au point jusqu'à ce qu'elle soit à son maximum. Cette méthode est entièrement basée sur un logiciel, ce qui en fait l’option la moins chère. Cependant, le processus est plus lent et ne fonctionne pas aussi bien dans des conditions de faible luminosité.

Les téléphones récents utilisent l'autofocus à détection de phase (PDAF), plus rapide et plus précis. Consultez les dernières caractéristiques techniques. iPhone 15 Pro Max Sur les appareils photo, vous remarquerez la mention PDAF. Cette dernière garantit que la même quantité de lumière atteint deux capteurs rapprochés sur le capteur d'image. Les systèmes PDAF classiques utilisent des photosites dédiés sur le capteur d'image pour mesurer la lumière provenant du côté gauche ou droit de l'objectif. Si les photosites de droite enregistrent la même intensité lumineuse que ceux de gauche, l'image est nette. Si l'intensité est différente, le système peut calculer la compensation nécessaire pour obtenir une image nette, ce qui est beaucoup plus rapide que les systèmes qui reposent sur la détection de contraste.

Les anciens systèmes PDAF n'utilisent que quelques pour cent de tous les sites d'images, tandis que les plus récents, comme le Galaxy S23 Ultra, en utilisent 100 pour cent. En plus des points d'image gauche et droit, les points d'image supérieur et inférieur sont également utilisés pour la mise au point.

Les iPhones disposent depuis longtemps d'un capteur LiDAR dédié qui améliore la mise au point, la perception de la profondeur, l'imagerie nocturne et est pratique pour les applications de réalité augmentée (AR).

Qu'est-ce qu'un capteur d'images ?

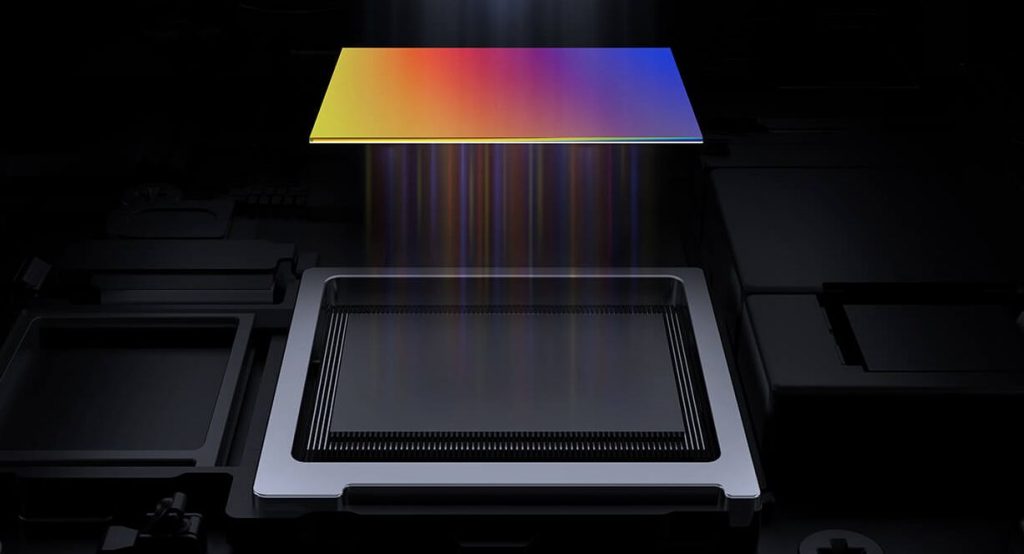

Le capteur n’est fondamentalement qu’une plaquette de silicium, dont beaucoup dépend. Le capteur reçoit la lumière et la convertit en signaux électriques. Un capteur peut comporter plusieurs millions de pixels. Comment pouvez-vous le découvrir ? Si vous voyez un appareil photo de 100 ou 200 MP, cela signifie que le capteur en question a 100 voire 200 mégapixels. Si la lumière de l'objectif n'atteint pas le point d'image, le capteur enregistre ce point d'image comme noir. Si la tache de l'image reçoit beaucoup de lumière, le capteur l'enregistre en blanc. Les nuances de gris que le capteur peut enregistrer sont appelées profondeur de bits.

La plupart des téléphones ont une profondeur de 8 bits, mais certains ont une profondeur de 10 bits. En comparaison, une profondeur de 8 bits signifie que la caméra peut capturer 256 teintes pour chaque canal de couleur primaire utilisé pour mélanger le spectre de couleurs (rouge, vert et bleu). Cela représente 256 nuances de rouge, vert et bleu. Au total, cela représente 16,7 millions de nuances de couleurs possibles. Les caméras 10 bits peuvent capturer plus d'un milliard de nuances.

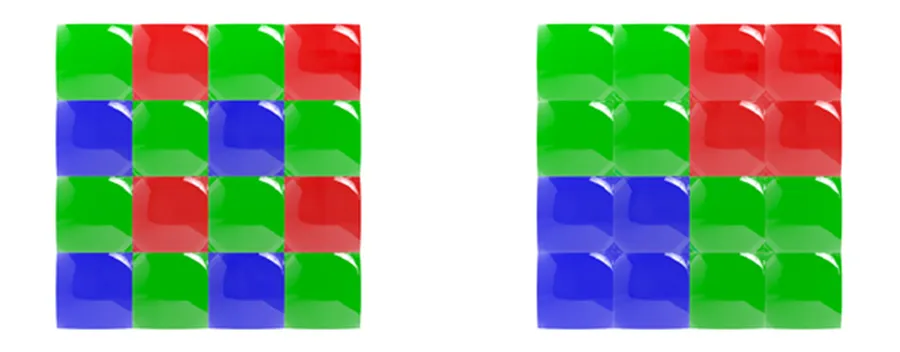

Comment un appareil photo prend-il une photo couleur ? Chaque pixel possède un filtre couleur qui ne laisse passer que certaines couleurs. À de rares exceptions près, comme les téléphones Huawei qui utilisent des filtres RYYB (jaune au lieu de vert), le filtre couleur le plus couramment utilisé est le filtre de Bayer, qui divise chaque carré (2 × 2) du pixel en filtres rouge, bleu et deux verts (RGGB).

Normalement, un appareil photo exécutant un ensemble de filtres Bayer additionnera toutes ces données de couleur en une seule valeur, mais le regroupement de pixels ne le fait pas. Les fabricants avaient besoin d’un moyen de collecter chaque couleur séparément.

À cette fin, ils ont conçu un réseau dit « quad-Bayer », où chaque groupe de pixels (2 × 2) se voit attribuer une couleur unique. Quatre de ces pixels sont ensuite combinés, comme pour le réseau de filtres Bayer original : 2 verts, 1 bleu et 1 rouge.

Le nouvel ensemble permet non seulement aux fabricants de smartphones de préserver les données de couleur lors du processus de combinaison des pixels, mais leur permet également d'introduire d'autres fonctionnalités innovantes telles que le mode HDR.

Revenons aux capteurs. Concernant les capteurs, il faut prêter attention à leur taille et à celle des pixels eux-mêmes. Les capteurs plus grands permettent de prendre de meilleures photos car ils possèdent davantage de pixels, qui sont également plus grands. Récemment, les smartphones et leurs appareils photo sont passés au format 1 pouce. Xiaomi 13 Pro Les vivo X90 Pro, par exemple, sont parmi les premiers à intégrer des capteurs de 1 pouce.

Les pixels sont mesurés en micromètres (µm). Des pixels plus grands peuvent absorber plus de lumière, ce qui est idéal pour la photographie de nuit. Ne vous inquiétez pas si votre téléphone a des pixels plus petits que les autres téléphones. En dehors de la photographie de nuit, il pourra toujours donner de bons résultats. Même les meilleurs téléphones Samsung ont du mal avec des pixels plus petits. Le Galaxy S23 Ultra dispose d'un capteur de 200 MP avec des pixels de 0,6 µm, tandis que l'iPhone 15 Pro Max dispose d'un capteur de 48 MP avec des pixels de 1,22 µm. Les fabricants ont donc commencé à utiliser la technologie du pixel binning. Le Galaxy S23 Ultra combine 16 pixels en un seul pour capturer des photos avec une résolution finale de 12 MP.

Stabilisation optique et électronique

La stabilisation est également importante pour capturer de bonnes photos et vidéos : optique ou électronique.

OIS est une solution matérielle qui utilise un gyroscope à système microélectromécanique (MEMS) pour détecter les mouvements et ajuster le système de caméra en conséquence. Exemple : si vous tenez un smartphone et que votre main bouge légèrement vers la gauche, le système OIS le détectera et déplacera légèrement la caméra vers la droite. Ceci est particulièrement important en photographie de nuit, lorsque l'appareil photo met beaucoup de temps à capter la lumière, période pendant laquelle les vibrations peuvent affecter la qualité de la photo.

La stabilisation électronique de l'image (EIS) s'appuie sur l'accéléromètre du téléphone pour détecter les mouvements. Au lieu de déplacer des parties de la caméra, elle déplace les images de l'image ou de l'éclairage. Étant donné que les expositions sont alignées en fonction du contenu de l'image et non du cadre du capteur d'image, l'image ou la vidéo finale a une résolution réduite.

Que fait le logiciel ?

Une fois que le capteur d'image a converti la lumière en signaux électriques, il incombe au processeur de signal d'image (ISP) de convertir ces nombres en image. Les données des signaux électriques sont essentiellement une image en noir et blanc. Le FAI doit d'abord renvoyer les données de couleur en fonction d'un ensemble de filtres de couleur (Bayer ou autre). Cela crée une image, mais les pixels ont des intensités différentes de rouge, vert ou bleu. Vient ensuite la reconstruction des couleurs, dans laquelle le FAI modifie les couleurs des pixels en fonction des couleurs des pixels voisins. Par exemple, s’il y a beaucoup de pixels verts et rouges et très peu de pixels bleus dans une certaine zone, les algorithmes de reconstruction des couleurs les convertissent en jaune.

ISP dispose également d'algorithmes de débruitage et d'accentuation une fois la reconstruction des couleurs effectuée. Chaque téléphone dispose alors de ses propres algorithmes spécifiques pour produire la photo finale.

La prochaine fois que vous prendrez votre téléphone, allumerez l'appareil photo et prendrez une photo, vous saurez ce qui se passait en arrière-plan à ce moment-là. Cela pourrait vous intéresser : Comment fonctionnent les montres connectées ? ou leurs capteurs ?