¿Qué es un chip NPU?

¿Qué es NPU de todos modos? ¿Cuál es su función? ¿Realmente lo necesitamos? Para muchos, basta con saber qué procesador y tarjeta gráfica se encuentran en una computadora, tableta o teléfono. Incluso aquellos de nosotros que probamos este tipo de dispositivos no hemos prestado demasiada atención a los chips NPU hasta ahora. Pero los tiempos están cambiando. La NPU es o será tan importante como el procesador (CPU) y la tarjeta gráfica (GPU).

¿Qué es la UNP?

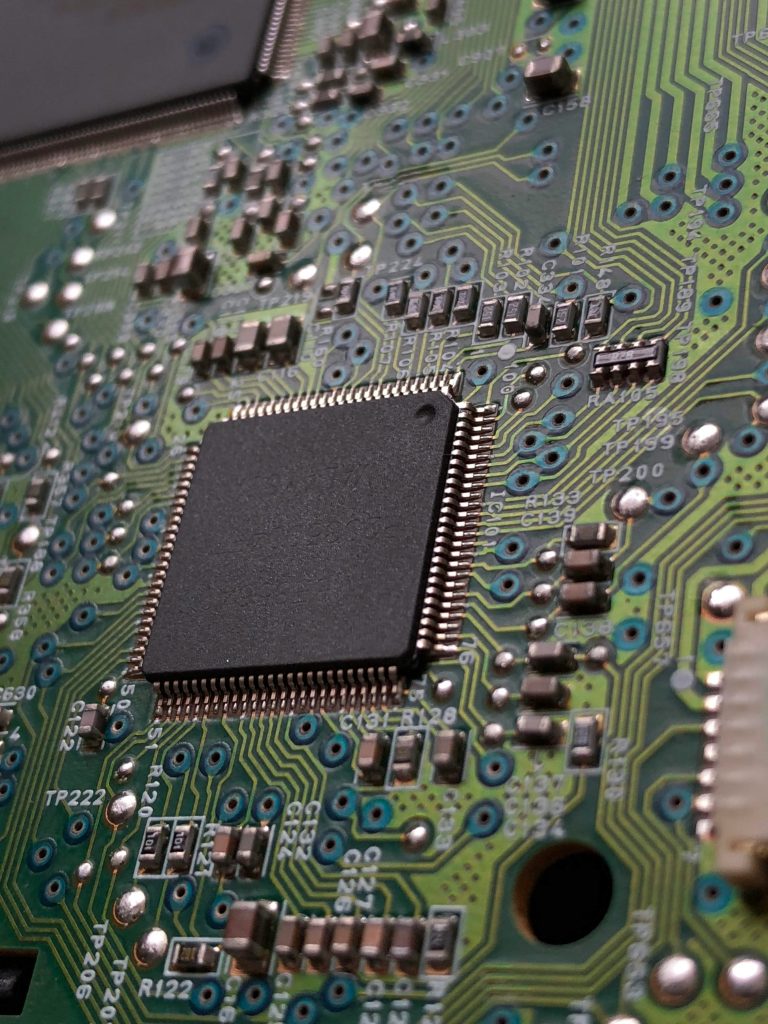

Una NPU, o unidad de procesamiento neuronal, es un procesador o unidad de procesamiento dedicado en un sistema en un chip (SoC) más grande diseñado específicamente para acelerar el rendimiento de redes neuronales y tareas de inteligencia artificial. A diferencia de las CPU y GPU de uso general, las NPU están optimizadas para la computación paralela basada en datos, por lo que son muy eficientes en el procesamiento de datos multimedia a gran escala, como vídeos e imágenes, y en el procesamiento de datos para redes neuronales. Son particularmente expertos en tareas relacionadas con la IA, como el reconocimiento de voz, el desenfoque del fondo en videollamadas y procedimientos de edición de fotografías o vídeos, como la detección de objetos, el borrado, la adición de elementos y similares.

Las NPU son circuitos integrados, pero se diferencian significativamente de los ASIC (circuitos integrados de aplicaciones específicas) de una sola función. Mientras que los ASIC están diseñados para un único propósito, como extraer una criptomoneda específica, los chips NPU ofrecen mayor complejidad y flexibilidad, satisfaciendo los diversos requisitos de la informática en red. Lo logran mediante programación especializada en software o hardware que se adapta a los requisitos únicos de los cálculos de redes neuronales.

En la mayoría de los productos de consumo, la NPU estará integrada en el procesador principal, como en las series Intel Core y Core Ultra o los nuevos procesadores para portátiles AMD Ryzen 8040. Sin embargo, en centros de datos más grandes u operaciones industriales más especializadas, la NPU puede estar integrada. un procesador completamente separado en la placa base, separado de todas las demás unidades de procesamiento. En los teléfonos, los chips NPU suelen estar integrados en un sistema en chip, donde también encontramos núcleos de procesador y gráficos.

Cada fabricante nombra sus chips NPU de forma ligeramente diferente. Apple los llama Neural Engine, Qualcomm eligió Hexagon, Google, por ejemplo, Tensor Processing Unit (TPU) y Huawei Da Vinci Architecture. Curiosamente, Huawei fue uno de los primeros en integrar la NPU en el smartphone Mate 10.

¿Por qué los teléfonos y las computadoras necesitan NPU?

Cuando Samsung presentó su concepto Galaxy AI a principios de este año, pudo haber sido la primera vez que se habló del chip NPU. ¿Por qué? Si logró probar sus funciones de IA, es posible que haya notado que algunas funcionan localmente y otras requieren una conexión a un servidor remoto. Si queremos que las funciones funcionen localmente, es decir, directamente en nuestro dispositivo, necesitamos NPU, especialmente si queremos que las tareas se ejecuten sin problemas.

Gran parte del procesamiento actual de la IA se realiza en la nube, pero esto no es lo ideal por varias razones. El primero es la latencia y los requisitos de red. Es posible que no pueda acceder a las herramientas cuando no esté conectado o que tenga que esperar largos tiempos de procesamiento durante las horas pico de tráfico. El envío de datos a través de Internet también es menos seguro, lo cual es un factor muy importante cuando se utiliza inteligencia artificial que tiene acceso a sus datos personales, como el ahora infame Recall de Microsoft.

Siempre que sea posible, el rendimiento local es mejor. Sin embargo, las funciones de IA no se quedan atrás; requieren bastante potencia. Si fuiste de los pocos que instalaron Stable Diffusion en tu ordenador al principio de la fiebre de la IA, entonces sabes qué tipo de hardware necesitas para obtener resultados razonablemente sólidos. Nadie quiere esperar demasiado, y aunque el procesador y la tarjeta gráfica podrían hacer mucho por sí solos, simplemente no serán suficientes a partir de ahora.

La solución son los chips NPU, que pueden acelerar significativamente este tipo de tareas. Su rendimiento a menudo se expresa en billones de operaciones por segundo (TOPS), pero no es una métrica muy útil porque no indica exactamente qué está haciendo cada operación. En cambio, a menudo es mejor buscar datos que indiquen qué tan rápido deben procesarse los tokens para modelos de lenguaje grandes, cuánta energía utilizan, qué tan precisos son, cuántos datos pueden leer o escribir, etc.

NPU y GPU. ¿Cual es la diferencia?

Aunque muchas cargas de trabajo de inteligencia artificial y aprendizaje automático se ejecutan en GPU, existe una diferencia importante entre una GPU y una NPU.

Aunque las GPU son conocidas por sus capacidades de computación paralela, no todas las GPU son capaces de manejar muchas otras tareas además de los gráficos, lo que requiere circuitos integrados especiales para manejar de manera eficiente las cargas de trabajo de aprendizaje automático. Las GPU de Nvidia más populares tienen estos circuitos en forma de núcleos Tensor, pero AMD e Intel también los han integrado en sus GPU, principalmente para manejar operaciones de alto nivel, una de las tareas de IA más comunes.

Con los chips NPU, podemos simplemente separar estos circuitos de la GPU, dejar que realice su tarea principal con todas sus fuerzas e integrar los circuitos separados en una unidad dedicada independiente. Esto permite que las tareas relacionadas con la IA se procesen de manera más eficiente con menos consumo de energía, razón por la cual se están convirtiendo en un componente indispensable en computadoras portátiles y teléfonos. Para aquellas tareas más exigentes, seguirán necesitando al menos la ayuda de un procesador gráfico.

NPU y CPU. ¿Qué hace uno, qué hace el otro?

Una NPU se diferencia de una unidad central de procesamiento (CPU) en la carga de trabajo para la que está diseñada. Un procesador típico de una computadora o teléfono tiene tareas muy generales y se adapta a ellas, ya que admite una amplia gama de comandos, diferentes formas de almacenamiento en caché y de invocación de funciones.

Como dijimos antes, las tareas de aprendizaje automático y de inteligencia artificial son diferentes y no requieren tanta flexibilidad. No sólo son más exigentes, sino que a menudo operan en formatos inusuales, como números de 16, 8 o 4 bits. Aunque los procesadores pueden realizar tareas básicas de aprendizaje automático, esta no es su tarea principal y son mucho más lentos en ello.

¿La UNP en el futuro ¿Componente requerido?

Es casi seguro, a menos que estés silbando a la IA.

Por ejemplo, si desea utilizar Microsoft Copilot Plus, necesitará un chip NPU con una capacidad mínima de 40 TOPS. Por ejemplo, podrá utilizar las funciones locales de IA Recall, Cocreator y Live Captions.

Al menos por ahora, no hay muchas aplicaciones que requieran un chip NPU como parte de sus términos de uso. Es probable que esto cambie a medida que los desarrolladores busquen integrar más funciones nativas, como Adobe, DaVinci Resolve o quizás Teams y Zoom.

También habrá que prestar atención a este componente en el caso de los teléfonos. Con los teléfonos premium, puede estar seguro de que tendrá acceso al mejor chip NPU y a todas las funciones de IA que el fabricante tiene para ofrecer. En las clases inferiores, por ejemplo por 500 euros o menos, esto no se da por sentado. Si quieres jugar con inteligencia artificial, lo más probable es que tengas que buscar en la clase de 1000 euros en adelante.

Por el momento, sin embargo, no tiene prisa por comprar una computadora o un teléfono nuevo. Estamos apenas al principio y, al menos por ahora, no te has perdido gran cosa.