¿Cómo funcionan las cámaras de los teléfonos inteligentes?

"¿Qué procesador tiene tu teléfono? ¿Cuanto espacio tiene? ¿Cuánta RAM?" Así es como solíamos comparar los teléfonos, pero hoy en día las preguntas más comunes son: "¿Qué tan buenas son las cámaras de tu teléfono? ¿Qué tan bien toma fotos y videos por la noche?” Al probar los teléfonos, todos, incluidos los evaluadores, incluidos nosotros en la oficina editorial, prestamos la mayor atención a las cámaras y solo entonces al rendimiento general del teléfono. Dado que hay bastantes incógnitas en torno a las cámaras y mucha terminología técnica (pantalla, sensores, lentes, enfoque...), puede que sea el momento de aclarar parte de la confusión sobre cómo funcionan.

Todo gira en torno a la luz.

Es sorprendente (o no) cuántos paralelismos podemos establecer entre la cámara y nuestro ojo. En cuartos oscuros, los ojos y las cámaras están ciegos. Para grabar una imagen, necesitamos luz. Pero la luz a menudo se dispersa en todas direcciones. Nuestros ojos tienen lentes que dirigen la luz hacia la retina. Incluso las cámaras de nuestros teléfonos tienen lentes que capturan y registran información sobre la luz.

La luz también puede dañar la fotografía, lo cual es más obvio en las cámaras analógicas que usan película fotográfica. Una exposición (demasiado) prolongada a la luz puede destruir el contenido de la película. La invención de la apertura resolvió este enigma. En las cámaras analógicas, el obturador es un mecanismo físico que se abre y se cierra rápidamente para controlar la cantidad de luz que llega a la película. Los párpados tienen una función similar.

Los teléfonos no tienen obturador físico, aunque se puede escuchar ese característico "clic" al tomar una foto. Es solo un efecto de audio. Pon tu teléfono en modo silencioso y el sonido desaparecerá. En lugar de obturadores físicos, las cámaras de los teléfonos usan un obturador electrónico, que hace lo mismo, pero lo hace todo con algoritmos en lugar de movimiento físico. Algunos smartphones, como Huawei Mate 50 Pro, por otro lado, tiene una cámara con un obturador físico que se puede mover entre posiciones preestablecidas.

La película aún no ha sido olvidada. Todavía se utiliza entre aficionados, fotógrafos profesionales e incluso en la industria cinematográfica. En otros lugares, ha sido sustituido por sensores.

¿Por qué los teléfonos móviles tienen lentes diferentes?

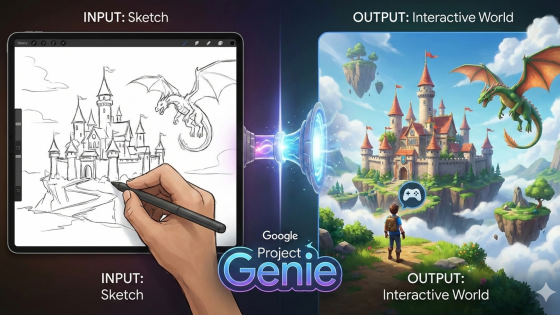

Probablemente hayas visto a un fotógrafo profesional cambiar las lentes de su cámara según la escena. Los teléfonos son técnicamente capaces de hacerlo, como lo ha demostrado Xiaomi con su teléfono conceptual. Concepto Xiaomi 12S UltraPero es extremadamente poco práctico y, además, surgen nuevos obstáculos, como problemas de durabilidad, resistencia al agua, precio elevado, etc. Por ello, los fabricantes han propuesto varias cámaras diferentes como solución, cada una con su propio objetivo específico, que se puede cambiar fácilmente desde la aplicación de la cámara según las necesidades. Hoy en día, la mayoría de las cámaras de los teléfonos funcionan de esta manera.

Si miras la parte trasera de tu teléfono, verás dos, tres o incluso cuatro lentes, y una en la pantalla frontal. Cada una ofrece un ángulo de visión, profundidad y características únicas. Como es lógico, la lente principal siempre está presente. Una cámara ultra gran angular también es prácticamente un estándar en los teléfonos móviles. En la gama baja, solemos encontrar una cámara macro, mientras que en los teléfonos premium encontramos un teleobjetivo y un teleobjetivo periscópico, como el del... Samsung Galaxy S23 Ultra.

¿Cuál es la función de la lente?

La apertura, la lente y el sensor de imagen están estrechamente relacionados. La apertura es la apertura que puedes ver físicamente en la lente de la cámara. Como se mencionó, la apertura controla la cantidad de luz que llegará a la lente y al sensor. Como regla general, una apertura mayor es mejor porque significa que la cámara puede utilizar más información de luz. Sin embargo, este no es necesariamente el mejor indicador de la calidad de las fotografías.

Si revisas las especificaciones de tu teléfono, verás una notación para los pasos "f" en las cámaras. Estos pasos representan la relación entre la distancia focal y el diámetro físico de la apertura. Cuanto menor sea este número, mayor será la apertura. Por ejemplo, vivo X90 Pro Tiene un objetivo principal con una apertura de f/1.8 y una distancia focal de 23 mm, un teleobjetivo de f/1.6 (50 mm), etcétera.

Le resultará difícil comparar el rendimiento de las cámaras de los teléfonos con la distancia focal. La distancia focal es extremadamente importante, pero para crear diferentes estéticas y efectos visuales. Una distancia focal más corta está pensada para una perspectiva de gran angular: los objetos cercanos parecen más grandes. Una distancia focal más larga, por ejemplo, crea una fotografía más proporcional y neutra.

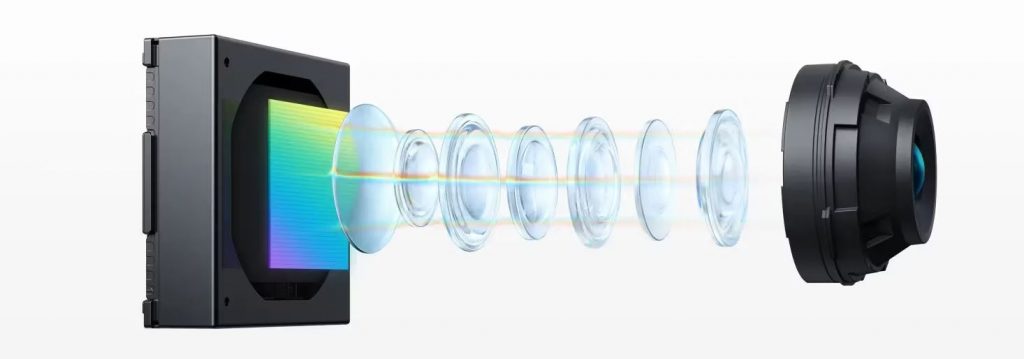

A medida que la luz ingresa al módulo de la cámara, la lente recoge la luz entrante de la toma y la dirige hacia el sensor. Las cámaras de los teléfonos inteligentes se componen de muchas lentes de plástico llamadas elementos. Debido a la naturaleza de la luz, diferentes longitudes de onda de luz (colores) se refractan (doblan) en diferentes ángulos al pasar a través de una lente. Esto significa que los colores de la escena se proyectan desalineados en el sensor de la cámara. Las cámaras necesitan múltiples lentes para transmitir una imagen clara al sensor sin posibles irregularidades como desalineación y otros efectos.

¿Cómo funciona el enfoque en las cámaras de los teléfonos inteligentes?

Irónicamente, el enfoque no es el enfoque del usuario porque normalmente lo controlan las propias cámaras. Hasta cierto punto, el enfoque se puede ajustar manualmente (según el teléfono), pero en la mayoría de los casos el software hace el trabajo tan bien que no es necesaria la intervención manual. Las cámaras de los teléfonos móviles utilizan un sensor dedicado y/o hardware adicional, como un telémetro láser, para enfocar.

El enfoque automático del software utiliza datos del sensor de imagen para determinar si la imagen está enfocada y ajusta las lentes para compensar. La técnica habitual del autoenfoque pasivo se basa en detectar el contraste de la imagen y ajustar el enfoque hasta que esté al máximo. Este método está completamente basado en software, lo que lo convierte en la opción más económica. Sin embargo, el proceso es más lento y no funciona tan bien en condiciones de poca luz.

Los teléfonos más nuevos utilizan el enfoque automático por detección de fase (PDAF), que es más rápido y preciso. Consulta las últimas especificaciones. iPhone 15 Pro Max En las cámaras, verá la etiqueta PDAF. Esta última garantiza que la misma cantidad de luz llegue a dos sensores muy próximos en el sensor de imagen. Los sistemas PDAF clásicos se basan en fotositios dedicados en el sensor de imagen para medir la luz que proviene del lado izquierdo o derecho del objetivo. Si los fotositios de la derecha registran la misma intensidad de luz que los de la izquierda, la imagen está enfocada. Si la intensidad no es la misma, el sistema puede calcular cuánto necesita compensar para obtener una imagen nítida, lo cual es mucho más rápido que los sistemas que se basan en la detección de contraste.

Los sistemas PDAF más antiguos utilizan sólo un pequeño porcentaje de todos los sitios de imágenes, mientras que los más nuevos, como el Galaxy S23 Ultra, utilizan el 100 por ciento. Además de los puntos de imagen izquierdo y derecho, los puntos de imagen superior e inferior también se utilizan para enfocar.

Los iPhone tienen desde hace mucho tiempo un sensor LiDAR dedicado que mejora el enfoque, la percepción de la profundidad, las imágenes nocturnas y es útil para aplicaciones de realidad aumentada (AR).

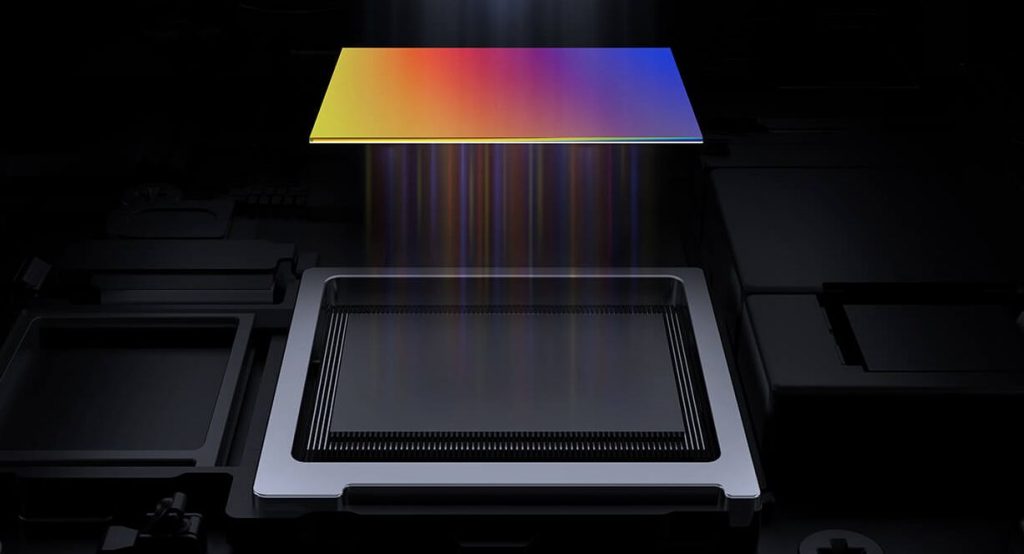

¿Qué es un sensor de imagen?

El sensor es básicamente una oblea de silicio, de la que depende mucho. El sensor recibe luz y la convierte en señales eléctricas. Un sensor puede tener varios millones de píxeles. ¿Cómo puedes descubrir eso? Si ves una cámara de 100 o 200 MP, significa que el sensor en cuestión tiene 100 o incluso 200 megapíxeles. Si la luz de la lente no llega al punto de la imagen, el sensor registra este punto de la imagen como negro. Si el punto de la imagen recibe mucha luz, el sensor lo registra como blanco. Los tonos de gris que el sensor puede registrar se denominan profundidad de bits.

La mayoría de los teléfonos tienen una profundidad de 8 bits, pero algunos tienen una profundidad de 10 bits. En comparación, la profundidad de 8 bits significa que la cámara puede capturar 256 tonos para cada canal de color primario utilizado para mezclar el espectro de colores (rojo, verde y azul). Son 256 tonos de rojo, verde y azul. En total, son 16,7 millones de tonos de color posibles. Las cámaras de 10 bits pueden capturar más de mil millones de sombras.

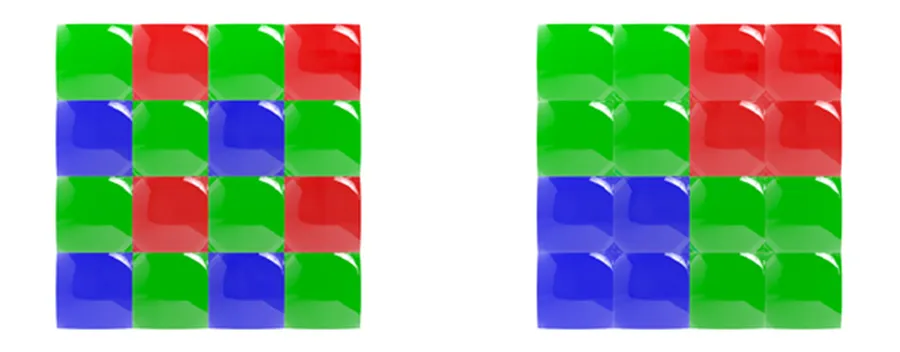

¿Cómo captura una cámara una foto a color? Cada píxel tiene un filtro de color que solo permite la entrada de ciertos colores. Con raras excepciones, como los teléfonos Huawei que usan filtros RYYB (amarillo en lugar de verde), la matriz de filtros de color más utilizada es la matriz Bayer, que divide cada cuadrado (2×2) del píxel en filtros rojo, azul y dos verdes (RGGB).

Normalmente, una cámara que ejecuta un conjunto de filtros Bayer sumará todos estos datos de color en un solo valor, pero la agrupación de píxeles no hace esto. Los fabricantes necesitaban una forma de recopilar cada color individualmente.

Para ello, diseñaron una matriz cuádruple Bayer, donde a cada grupo de píxeles (2×2) se le asigna un solo color. Cuatro de estos se combinan, de forma similar a la matriz de filtros Bayer original: 2x verde, 1x azul, 1x rojo.

El nuevo conjunto no sólo permite a los fabricantes de teléfonos inteligentes conservar los datos de color en el proceso de combinación de píxeles, sino que también les permite introducir otras funciones innovadoras como el modo HDR.

Volvamos a los sensores. En cuanto a los sensores, hay que prestar atención a su tamaño y al de los píxeles. Los sensores más grandes pueden capturar mejores fotos porque tienen más píxeles, que también son más grandes. Recientemente, los smartphones o sus cámaras han entrado en el mundo de la pulgada. Xiaomi 13 Pro Los vivo X90 Pro, por ejemplo, están entre los primeros en incorporar sensores de 1 pulgada.

Los píxeles se miden en micrómetros (μm). Los píxeles más grandes pueden absorber más luz, lo que es bueno para la fotografía nocturna. No se preocupe si su teléfono tiene píxeles más pequeños que otros teléfonos. Fuera de la fotografía nocturna, aún podrá ofrecer buenos resultados. Incluso los mejores teléfonos Samsung tienen problemas con los píxeles más pequeños. El Galaxy S23 Ultra tiene un sensor de 200 MP con píxeles de 0,6 µm, mientras que el iPhone 15 Pro Max tiene un sensor de 48 MP con píxeles de 1,22 µm. Por lo tanto, los fabricantes han comenzado a utilizar la tecnología de agrupación de píxeles. El Galaxy S23 Ultra combina 16 píxeles en uno para capturar fotografías con una resolución final de 12 MP.

Estabilización óptica y electrónica.

La estabilización también es importante para capturar buenas fotografías y vídeos: óptica o electrónica.

OIS es una solución de hardware que utiliza un giroscopio de sistema microelectromecánico (MEMS) para detectar movimiento y ajustar el sistema de cámara en consecuencia. Ejemplo: si sostienes un smartphone y tu mano se mueve ligeramente hacia la izquierda, el sistema OIS lo detectará y moverá la cámara ligeramente hacia la derecha. Esto es especialmente importante en fotografía nocturna, cuando la cámara tarda mucho en capturar la luz, tiempo durante el cual las vibraciones pueden afectar la calidad de la foto.

La Estabilización Electrónica de Imagen (EIS) se basa en el acelerómetro del teléfono para detectar movimiento. En lugar de mover partes de la cámara, mueve fotogramas de la imagen o la iluminación. Debido a que las exposiciones se alinean según el contenido de la imagen y no el marco del sensor de imagen, la imagen o el videoclip final tiene una resolución reducida.

¿Qué hace el software?

Después de que el sensor de imagen convierte la luz en señales eléctricas, es trabajo del procesador de señales de imagen (ISP) convertir esos números en una imagen. Los datos de las señales eléctricas son esencialmente una imagen en blanco y negro. El ISP primero debe devolver los datos de color basándose en un conjunto de filtros de color (Bayer u otra cosa). Esto crea una imagen, pero los píxeles tienen diferentes intensidades de rojo, verde o azul. A esto le sigue la reconstrucción del color, donde el ISP cambia los colores de los píxeles en función de los colores de los píxeles vecinos. Por ejemplo, si hay muchos píxeles verdes y rojos y muy pocos píxeles azules en un área determinada, los algoritmos de reconstrucción de color los convierten a amarillo.

El ISP también tiene algoritmos de eliminación de ruido y nitidez después de realizar la reconstrucción del color. Cada teléfono tiene sus propios algoritmos específicos para producir la foto final.

La próxima vez que tomes tu teléfono, enciendas la cámara y tomes una foto, sabrás qué estaba pasando en ese momento. Quizás te interese: ¿Cómo funcionan los relojes inteligentes? ¿o sus sensores?