Was ist ein NPU-Chip?

Was ist überhaupt NPU? Welche Funktion hat es? Brauchen wir es wirklich? Für viele reicht es aus zu wissen, welcher Prozessor und welche Grafikkarte sich in einem Computer, Tablet oder Telefon befinden. Selbst diejenigen von uns, die diese Art von Geräten testen, haben den NPU-Chips bisher nicht allzu viel Aufmerksamkeit geschenkt. Aber die Zeiten ändern sich. Die NPU ist oder wird genauso wichtig wie der Prozessor (CPU) und die Grafikkarte (GPU).

Was ist NPU?

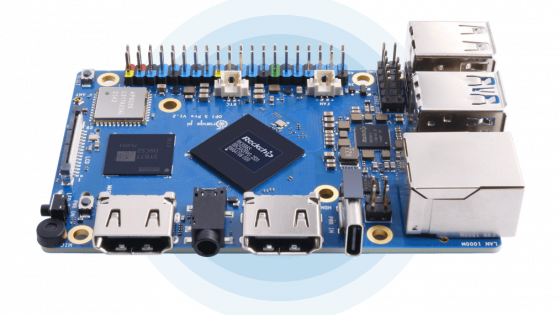

Eine NPU oder neuronale Verarbeitungseinheit ist ein dedizierter Prozessor oder eine Verarbeitungseinheit in einem größeren System-on-a-Chip (SoC), der speziell dafür entwickelt wurde, die Leistung neuronaler Netze und Aufgaben der künstlichen Intelligenz zu beschleunigen. Im Gegensatz zu Allzweck-CPUs und GPUs sind NPUs für datengesteuertes Parallelrechnen optimiert, sodass sie große Multimediadaten wie Videos und Bilder sehr effizient verarbeiten und Daten für neuronale Netze verarbeiten können. Sie beherrschen insbesondere KI-bezogene Aufgaben wie Spracherkennung, Hintergrundunschärfe bei Videoanrufen sowie Foto- oder Videobearbeitungsverfahren wie Objekterkennung, Löschen, Hinzufügen von Elementen und mehr.

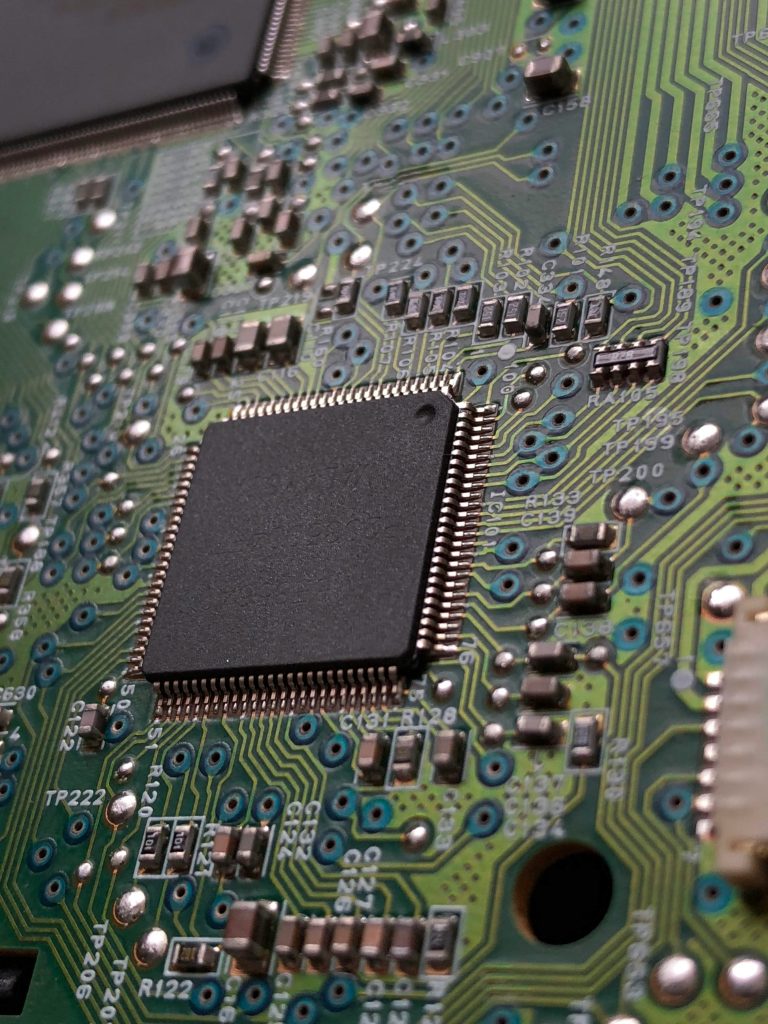

NPUs sind integrierte Schaltkreise, unterscheiden sich aber deutlich von Einzelfunktions-ASICs (Application-Specific Integrated Circuits). Während ASICs für einen einzigen Zweck konzipiert sind, beispielsweise das Mining einer bestimmten Kryptowährung, bieten NPU-Chips eine größere Komplexität und Flexibilität und erfüllen die unterschiedlichen Anforderungen des Netzwerk-Computing. Dies erreichen sie durch spezielle Programmierung in Software oder Hardware, die auf die besonderen Anforderungen neuronaler Netzwerkberechnungen zugeschnitten ist.

In den meisten Verbraucherprodukten ist die NPU tatsächlich in den Hauptprozessor integriert, wie in den Intel Core- und Core Ultra-Serien oder den neuen AMD Ryzen 8040-Laptop-Prozessoren. In größeren Rechenzentren oder spezialisierteren Industriebetrieben kann dies jedoch der Fall sein ein völlig separater Prozessor auf der Hauptplatine, getrennt von allen anderen Verarbeitungseinheiten. Bei Telefonen sind NPU-Chips normalerweise in einem System-on-Chip integriert, wo wir auch Prozessor- und Grafikkerne finden.

Jeder Hersteller benennt seine NPU-Chips etwas anders. Apple nennt sie Neural Engine, Qualcomm wählte Hexagon, Google beispielsweise Tensor Processing Unit (TPU) und Huawei Da Vinci Architecture. Interessanterweise gehörte Huawei zu den ersten Unternehmen, die die NPU in das Mate 10-Smartphone integriert haben.

Warum brauchen Telefone und Computer überhaupt NPUs?

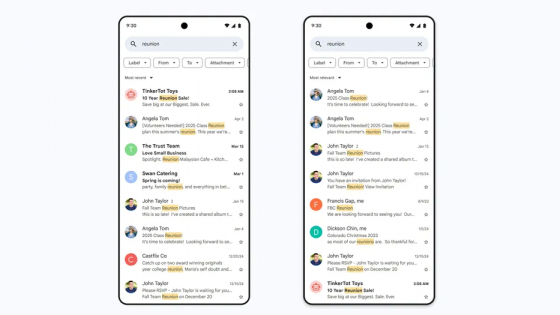

Als Samsung Anfang des Jahres sein Galaxy AI-Konzept vorstellte, war es möglicherweise das erste Mal, dass über den NPU-Chip gesprochen wurde. Warum? Wenn Sie es geschafft haben, ihre KI-Funktionen zu testen, ist Ihnen vielleicht aufgefallen, dass einige lokal funktionieren und andere eine Verbindung zu einem Remote-Server erfordern. Wenn wir möchten, dass Funktionen lokal, also direkt auf unserem Gerät, funktionieren, benötigen wir NPU, insbesondere wenn wir möchten, dass Aufgaben fehlerfrei laufen.

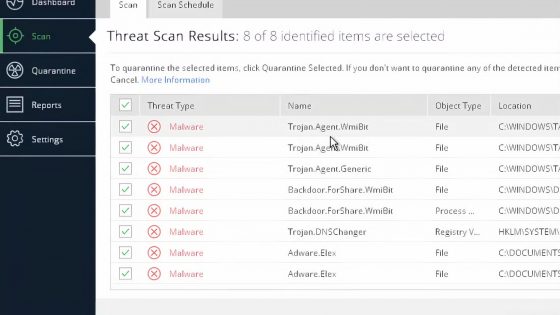

Ein Großteil der heutigen KI-Verarbeitung erfolgt in der Cloud, was jedoch aus mehreren Gründen nicht ideal ist. Die erste betrifft Latenz- und Netzwerkanforderungen. Möglicherweise können Sie nicht auf die Tools zugreifen, wenn Sie offline sind, oder Sie müssen bei Spitzenlast auf lange Verarbeitungszeiten warten. Das Versenden von Daten über das Internet ist außerdem weniger sicher, was ein sehr wichtiger Faktor ist, wenn künstliche Intelligenz eingesetzt wird, die Zugriff auf Ihre persönlichen Daten hat, wie etwa der mittlerweile berüchtigte Recall von Microsoft.

Wo möglich, ist eine lokale Bedienung besser. Allerdings sind KI-Funktionen kein Kinderspiel, sondern erfordern einiges an Leistung. Wenn Sie zu den wenigen gehören, die Stable Diffusion zu Beginn des KI-Trends auf Ihrem PC installiert haben, wissen Sie, welche Art von Hardware Sie benötigen, um relativ solide Ergebnisse zu erzielen. Niemand möchte zu lange warten, und obwohl CPU und Grafikkarte alleine schon einiges leisten könnten, wird es von nun an einfach nicht mehr ausreichen.

Die Lösung sind NPU-Chips, die solche Aufgaben deutlich beschleunigen können. Ihre Leistung wird oft in Billionen Operationen pro Sekunde (TOPS) angegeben, aber das ist keine sehr nützliche Kennzahl, da sie nicht genau sagt, was jede Operation tut. Stattdessen ist es oft besser, nach Daten zu suchen, die Aufschluss darüber geben, wie schnell Token für große Sprachmodelle verarbeitet werden müssen, wie viel Strom sie verbrauchen, wie genau sie sind, wie viele Daten sie lesen oder schreiben können usw.

NPUs und GPUs. Was ist der Unterschied?

Obwohl viele KI- und Machine-Learning-Workloads auf GPUs laufen, gibt es einen wichtigen Unterschied zwischen einer GPU und einer NPU.

Obwohl GPUs für ihre parallelen Rechenfähigkeiten bekannt sind, sind nicht alle GPUs in der Lage, neben der Grafik auch eine Reihe anderer Aufgaben zu bewältigen, da sie spezielle integrierte Schaltkreise benötigen, um Arbeitslasten des maschinellen Lernens effizient zu bewältigen. Die beliebtesten Nvidia-GPUs verfügen über diese Schaltkreise in Form von Tensor-Kernen, aber auch AMD und Intel haben sie in ihre GPUs eingebaut, hauptsächlich um anspruchsvolle Operationen zu bewältigen, eine der häufigsten KI-Aufgaben.

Mit NPU-Chips können wir diese Schaltkreise einfach von der GPU trennen, sie mit aller Kraft ihrer Hauptaufgabe nachgehen lassen und die einzelnen Schaltkreise in einer eigenständigen dedizierten Einheit integrieren. Dadurch können KI-bezogene Aufgaben effizienter und mit weniger Stromverbrauch bearbeitet werden, was auch der Grund dafür ist, dass sie zu einem unverzichtbaren Bestandteil in Laptops und Telefonen werden. Für die anspruchsvollsten Aufgaben benötigen sie dennoch mindestens die Hilfe eines Grafikprozessors.

NPU und CPU. Was macht der eine, was macht der andere?

Eine NPU unterscheidet sich von einer Zentraleinheit (CPU) durch die Arbeitslast, für die sie ausgelegt ist. Ein typischer Prozessor in einem Computer oder Telefon hat sehr allgemeine Aufgaben und ist dafür geeignet, da er eine breite Palette von Befehlen, verschiedene Arten des Cachings und Aufrufens von Funktionen unterstützt.

Wie bereits erwähnt, sind die Aufgaben des maschinellen Lernens und der künstlichen Intelligenz unterschiedlich und erfordern nicht so viel Flexibilität. Sie sind nicht nur anspruchsvoller, sondern arbeiten oft auch mit ungewöhnlichen Formaten wie 16-, 8- oder 4-Bit-Zahlen. Obwohl Prozessoren grundlegende Aufgaben des maschinellen Lernens ausführen können, ist dies nicht ihre Hauptaufgabe und sie sind dabei viel langsamer.

Wird die NPU in der Zukunft erforderliche Komponente?

Mit ziemlicher Sicherheit, es sei denn, Sie pfeifen auf KI.

Wenn Sie beispielsweise Microsoft Copilot Plus nutzen möchten, benötigen Sie einen NPU-Chip mit einer Mindestkapazität von 40 TOPS. Beispielsweise können Sie die lokalen KI-Funktionen Recall, Cocreator und Live Captions nutzen.

Zumindest im Moment gibt es nicht viele Apps, die in ihren Nutzungsbedingungen einen NPU-Chip erfordern. Dies wird sich wahrscheinlich ändern, da Entwickler versuchen, mehr native Funktionen wie Adobe, DaVinci Resolve oder vielleicht Teams und Zoom zu integrieren.

Auch bei Telefonen muss auf diese Komponente geachtet werden. Bei Premium-Telefonen können Sie sicher sein, dass Sie Zugriff auf den besten NPU-Chip und alle KI-Funktionen haben, die der Hersteller zu bieten hat. In den unteren Klassen, beispielsweise für 500 Euro und weniger, ist dies keine Selbstverständlichkeit. Wer mit künstlicher Intelligenz spielen möchte, muss höchstwahrscheinlich in der 1000-Euro-Klasse aufwärts suchen.

Im Moment haben Sie es jedoch nicht eilig, einen neuen Computer oder ein neues Telefon zu kaufen. Wir stehen erst am Anfang und Sie haben zumindest im Moment noch nicht viel verpasst.