Wie funktionieren Smartphone-Kameras?

„Welchen Prozessor hat Ihr Telefon? Wie viel Platz hat es? Wie viel RAM?“ So haben wir früher Telefone verglichen, aber heute lauten die häufigeren Fragen: „Wie gut sind die Kameras Ihres Telefons?“ Wie gut macht es nachts Fotos und Videos?“ Beim Testen von Handys achten alle, auch die Tester, also auch wir in der Redaktion, vor allem auf die Kameras und erst dann auf die Gesamtleistung des Handys. Da es rund um Kameras einige Unbekannte und viele technische Begriffe (Bildschirm, Sensoren, Objektive, Fokus...) gibt, ist es vielleicht an der Zeit, den Nebel um ihre Funktionsweise aufzuklären.

Alles dreht sich um Licht

Es ist überraschend (oder auch nicht), wie viele Parallelen wir zwischen der Kamera und unserem Auge herstellen können. In dunklen Räumen sind Augen und Kameras blind. Um ein Bild aufzunehmen, brauchen wir Licht. Doch das Licht wird oft in alle Richtungen gestreut. Unsere Augen haben Linsen, die Licht auf die Netzhaut lenken. Sogar die Kameras unserer Telefone verfügen über Objektive, die Lichtinformationen erfassen und aufzeichnen.

Auch Licht kann der Fotografie schaden, was am offensichtlichsten bei analogen Kameras ist, die Fotofilme verwenden. (Zu) lange Lichteinwirkung kann den Inhalt des Films zerstören. Die Erfindung der Blende löste dieses Rätsel. Bei analogen Kameras ist der Verschluss ein physikalischer Mechanismus, der sich schnell öffnet und schließt, um die Lichtmenge zu steuern, die den Film erreicht. Die Augenlider haben eine ähnliche Funktion.

Die Telefone verfügen über keinen physischen Verschluss, Sie hören jedoch beim Aufnehmen eines Fotos das charakteristische „Klick“-Geräusch. Es ist nur ein Soundeffekt. Schalten Sie das Telefon in den lautlosen Modus und der Ton verschwindet. Anstelle physischer Auslöser verwenden die Kameras von Telefonen einen elektronischen Verschluss, der die gleiche Funktion hat, aber alles mit Algorithmen und nicht mit physischer Bewegung erledigt. Einige Smartphones, wie zum Beispiel das Huawei Mate 50 Pro, verfügen über eine Kamera mit einer physischen Blende, die zwischen voreingestellten Positionen bewegt werden kann.

Der Film ist noch nicht in Vergessenheit geraten. Es wird immer noch von Hobbyfotografen, professionellen Fotografen und sogar in der Filmindustrie verwendet. An anderer Stelle wurde es durch Sensoren ersetzt.

Warum haben Mobiltelefone unterschiedliche Objektive?

Sie haben wahrscheinlich schon gesehen, wie ein professioneller Fotograf je nach der Szene vor ihm die Objektive seiner Kamera wechselte. Telefone sind technisch dazu in der Lage, wie Xiaomi mit dem Xiaomi 12S Ultra Concept-Telefon bewiesen hat, aber es ist äußerst unpraktisch und es entstehen neue Hindernisse wie Haltbarkeitsprobleme, Wasserbeständigkeit, hoher Preis und dergleichen. Daher haben die Hersteller als Lösung mehrere unterschiedliche Kameras vorgeschlagen – jede mit ihrem eigenen spezifischen Objektiv, zwischen denen innerhalb der Kameraanwendung je nach Bedarf problemlos gewechselt werden kann. Heutzutage funktionieren die meisten Telefonkameras auf diese Weise.

Wenn Sie auf die Rückseite Ihres Telefons schauen, werden Sie zwei, drei oder sogar vier Linsen und eine auf dem Display vorne bemerken. Jedes bietet eine andere Perspektive, Tiefe und seine eigenen einzigartigen Merkmale. Das Hauptobjektiv ist verständlicherweise immer vorhanden. Auch bei Mobiltelefonen ist die Ultra-Wide-Kamera mehr oder weniger eine Konstante. In der unteren Klasse finden wir häufig eine Makrokamera, während Premium-Telefone über ein Teleobjektiv und ein Periskop-Teleobjektiv verfügen, wie beispielsweise das Samsung Galaxy S23 Ultra.

Welche Funktion hat das Objektiv?

Blende, Objektiv und Bildsensor hängen eng zusammen. Die Blende ist die Öffnung, die Sie physisch auf dem Kameraobjektiv sehen können. Wie bereits erwähnt, steuert die Blende, wie viel Licht das Objektiv und den Sensor erreicht. Im Allgemeinen ist eine größere Blende besser, da die Kamera dadurch mehr Lichtinformationen nutzen kann. Dies ist jedoch nicht unbedingt der beste Indikator für die Fotoqualität.

Wenn Sie sich die technischen Daten Ihres Telefons ansehen, werden Sie feststellen, dass die Kameras mit „f“ bewertet sind. Diese Grade sind das Verhältnis der Brennweite zum physikalischen Durchmesser der Blende. Je kleiner diese Zahl ist, desto größer ist die Blende. Beispielsweise verfügt das vivo X90 Pro über ein f/1,8-Hauptobjektiv mit 23 mm Brennweite, ein SF/1,6-Teleobjektiv (50 mm) und so weiter.

Es wird Ihnen schwerfallen, die Leistung von Telefonkameras mit der Brennweite zu vergleichen. Die Brennweite ist äußerst wichtig, aber auch für die Erzielung verschiedener Ästhetiken und visueller Effekte. Eine kürzere Brennweite ist für eine Weitwinkelperspektive gedacht – Objekte in der Nähe erscheinen größer. Eine längere Brennweite sorgt beispielsweise für ein proportionaleres und neutraleres Foto.

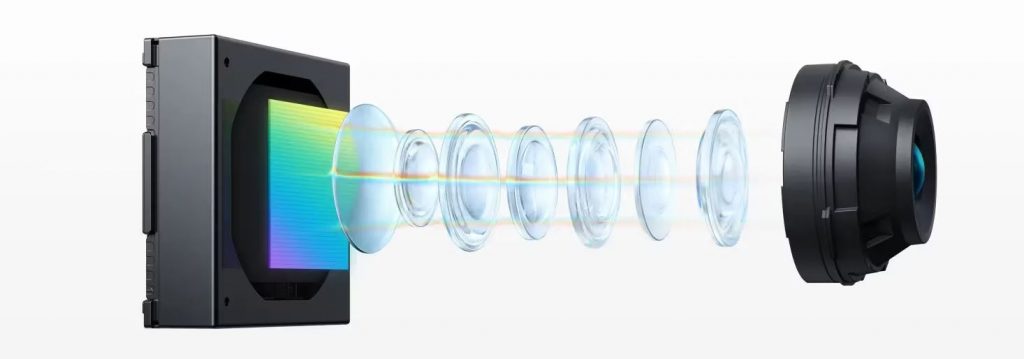

Wenn Licht in das Kameramodul eindringt, sammelt das Objektiv das einfallende Licht der Aufnahme und leitet es auf den Sensor. Smartphone-Kameras bestehen aus vielen Kunststofflinsen, sogenannten Elementen. Aufgrund der Natur des Lichts werden Licht unterschiedlicher Wellenlängen (Farben) beim Durchgang durch eine Linse in unterschiedlichen Winkeln gebrochen (gebeugt). Das bedeutet, dass die Farben Ihrer Szene nicht richtig auf den Kamerasensor projiziert werden. Kameras benötigen mehrere Linsen, um ein klares Bild ohne mögliche Unregelmäßigkeiten wie Fehlausrichtung und andere Effekte an den Sensor zu übertragen.

Wie funktioniert der Fokus bei Smartphone-Kameras?

Ironischerweise liegt die Fokussierung nicht im Fokus des Benutzers, da diese normalerweise von den Kameras selbst gesteuert wird. Bis zu einem gewissen Grad kann der Fokus manuell angepasst werden (abhängig vom Telefon), aber in den meisten Fällen erledigt die Software diese Aufgabe so gut, dass ein manueller Eingriff nicht erforderlich ist. Mobiltelefonkameras verwenden zum Fokussieren einen speziellen Sensor und/oder zusätzliche Hardware wie einen Laser-Entfernungsmesser.

Der Software-Autofokus ermittelt anhand der Daten des Bildsensors, ob das Bild scharf ist, und passt die Objektive entsprechend an. Die übliche Technik des passiven Autofokus basiert auf der Erkennung des Bildkontrasts und der Einstellung des Fokus, bis er sein Maximum erreicht. Diese Methode ist vollständig softwarebasiert und damit die günstigste Variante. Allerdings ist der Vorgang langsamer und funktioniert bei schlechten Lichtverhältnissen nicht so gut.

Neuere Telefone verwenden den Phasendetektions-Autofokus (PDAF), der schneller und genauer ist. Sehen Sie sich die technischen Daten des neuesten iPhone 15 Pro Max an und Sie werden das PDAF-Tag auf den Kameras bemerken. Letzteres sorgt dafür, dass die gleiche Lichtmenge auf zwei nahe beieinander liegende Sensoren auf dem Bildsensor gelangt. Klassische PDAF-Systeme basieren auf diesen speziellen Fotostellen auf dem Bildsensor, um das von der linken oder rechten Seite des Objektivs kommende Licht zu messen. Wenn die Bildpunkte auf der rechten Seite die gleiche Lichtintensität registrieren wie die Punkte auf der linken Seite, ist das Bild scharf. Wenn die Intensität nicht gleich ist, kann das System berechnen, wie viel es zum Ausgleich eines scharfen Bildes benötigt, was viel schneller geht als bei Systemen, die auf Kontrasterkennung basieren.

Ältere PDAF-Systeme nutzen nur wenige Prozent aller Bildseiten, während neuere, wie das Galaxy S23 Ultra, alle 100 Prozent nutzen. Zur Fokussierung werden neben dem linken und rechten Bildpunkt auch der obere und untere Bildpunkt verwendet.

iPhones verfügen seit langem über einen speziellen LiDAR-Sensor, der den Fokus, die Tiefenwahrnehmung und Nachtaufnahmen verbessert und praktisch für Augmented Reality (AR)-Anwendungen ist.

Was ist ein Bildsensor?

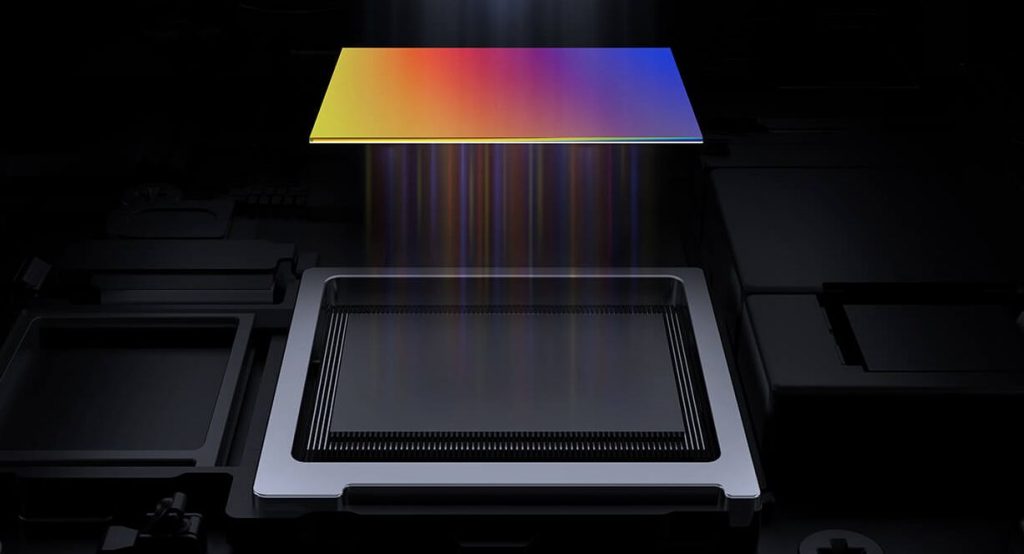

Der Sensor ist im Grunde nur ein Siliziumwafer, von dem viel abhängt. Der Sensor empfängt Licht und wandelt es in elektrische Signale um. Ein Sensor kann mehrere Millionen Pixel haben. Wie kann man das herausfinden? Wenn Sie eine 100- oder 200-MP-Kamera sehen, bedeutet das, dass der betreffende Sensor 100 oder sogar 200 Megapixel hat. Erreicht das Licht des Objektivs den Bildpunkt nicht, registriert der Sensor diesen Bildpunkt als schwarz. Erhält der Bildpunkt viel Licht, wird er vom Sensor als weiß erfasst. Die Graustufen, die der Sensor registrieren kann, werden als Bittiefe bezeichnet.

Die meisten Telefone verfügen über eine 8-Bit-Tiefe, einige jedoch auch über eine 10-Bit-Tiefe. Im Vergleich dazu bedeutet eine 8-Bit-Tiefe, dass die Kamera 256 Farbtöne für jeden Primärfarbkanal erfassen kann, der zum Mischen des Farbspektrums (Rot, Grün und Blau) verwendet wird. Das sind 256 Rot-, Grün- und Blautöne. Insgesamt sind das 16,7 Millionen mögliche Farbtöne. 10-Bit-Kameras können mehr als eine Milliarde Farbtöne erfassen.

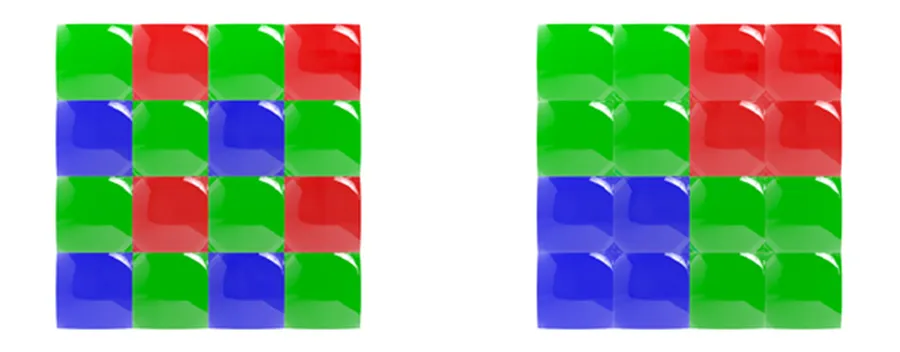

Wie nimmt eine Kamera ein Farbfoto auf? Jeder Bildpunkt verfügt über einen Farbfilter, der nur bestimmte Farben durchlässt. Mit seltenen Ausnahmen, wie z. B. Huawei-Telefonen, die RYYB (Gelb- statt Grünfilter) verwenden, wird am häufigsten das Bayer-Farbfilterarray verwendet, das jedes Quadrat (2×2) des Bildflecks in Rot, Blau und zwei Grün unterteilt Filter (RGGB).

Normalerweise summiert eine Kamera, die einen Satz Bayer-Filter verwendet, alle diese Farbdaten zu einem Wert, aber durch Pixel-Binning ist das nicht möglich. Die Hersteller brauchten eine Möglichkeit, jede Farbe einzeln zu erfassen.

Zu diesem Zweck entwarfen sie ein sogenanntes Quad-Bayer-Array, bei dem jeder Pixelgruppe (2×2) eine Farbe zugeordnet ist. Vier davon werden dann miteinander kombiniert – ähnlich wie beim ursprünglichen Bayer-Filtersatz: 2x Grün, 1x Blau, 1x Rot.

Das neue Set ermöglicht es Smartphone-Herstellern nicht nur, Farbdaten beim Kombinieren von Pixeln beizubehalten, sondern ermöglicht ihnen auch die Einführung anderer innovativer Funktionen wie des HDR-Modus.

Kommen wir zurück zu den Sensoren. Bei Sensoren muss auf deren Größe und die Größe der Pixel selbst geachtet werden. Größere Sensoren können bessere Fotos aufnehmen, da sie über mehr und gleichzeitig größere Bildbereiche verfügen. Vor kurzem haben Smartphones und ihre Kameras die 1-Zoll-Welt betreten. Beispielsweise gehören das Xiaomi 13 Pro und das vivo X90 Pro zu den ersten, die über 1-Zoll-Sensoren verfügen.

Pixel werden in Mikrometern (µm) gemessen. Größere Pixel können mehr Licht absorbieren, was für Nachtaufnahmen gut ist. Machen Sie sich keine Sorgen, wenn Ihr Telefon kleinere Pixel als andere Telefone hat. Außerhalb der Nachtfotografie wird es dennoch gute Ergebnisse liefern können. Selbst die besten Samsung-Handys haben mit kleineren Pixeln zu kämpfen. Das Galaxy S23 Ultra verfügt über einen 200-MP-Sensor mit 0,6 µm Pixeln, während das iPhone 15 Pro Max über einen 48 MP-Sensor mit 1,22 µm Pixeln verfügt. Daher haben Hersteller damit begonnen, die Pixel-Binning-Technologie einzusetzen. Das Galaxy S23 Ultra kombiniert 16 Pixel in einem, um Fotos mit einer Endauflösung von 12 MP aufzunehmen.

Optische und elektronische Stabilisierung

Für die Aufnahme guter Fotos und Videos ist auch die Stabilisierung wichtig: optisch oder elektronisch.

OIS ist eine Hardwarelösung, die ein Gyroskop eines mikroelektromechanischen Systems (MEMS) verwendet, um Bewegungen zu erkennen und das Kamerasystem entsprechend anzupassen. Beispiel: Wenn Sie ein Smartphone halten und Ihre Hand leicht nach links bewegt, erkennt das OIS-System dies und bewegt die Kamera leicht nach rechts. Dies ist besonders wichtig bei Nachtaufnahmen, wenn die Kamera lange braucht, um das Licht einzufangen, und Vibrationen während dieser Zeit die Qualität des Fotos beeinträchtigen können.

Die elektronische Bildstabilisierung (EIS) nutzt den Beschleunigungsmesser des Telefons, um Bewegungen zu erkennen. Anstatt Teile der Kamera zu bewegen, werden Bildausschnitte oder Beleuchtung verschoben. Da die Belichtungen auf der Grundlage des Bildinhalts und nicht des Bildsensorrahmens ausgerichtet werden, weist das endgültige Bild oder der endgültige Videoclip eine reduzierte Auflösung auf.

Was macht die Software?

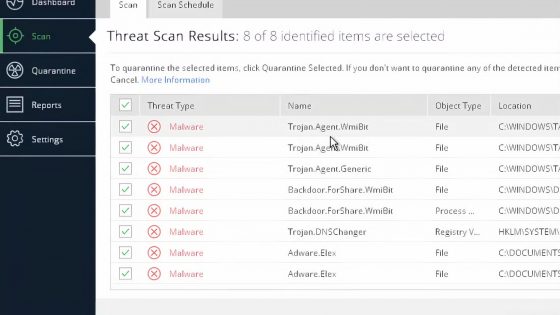

Nachdem der Bildsensor das Licht in elektrische Signale umgewandelt hat, ist es die Aufgabe des Bildsignalprozessors (ISP), diese Zahlen in ein Bild umzuwandeln. Die Daten in elektrischen Signalen sind im Wesentlichen ein Schwarzweißbild. Der ISP muss zunächst die Farbdaten basierend auf einem Satz Farbfilter (Bayer oder etwas anderes) zurückgeben. Dadurch entsteht ein Bild, aber die Pixel haben unterschiedliche Intensitäten von Rot, Grün oder Blau. Darauf folgt die Farbrekonstruktion, bei der der ISP die Farben der Pixel basierend auf den Farben benachbarter Pixel ändert. Wenn beispielsweise in einem bestimmten Bereich viele grüne und rote Pixel und nur sehr wenige blaue Pixel vorhanden sind, werden diese von den Farbrekonstruktionsalgorithmen in Gelb umgewandelt.

ISP verfügt außerdem über Algorithmen zur Rauschunterdrückung und Schärfung nach der Farbrekonstruktion. Jedes Telefon verfügt dann über seine eigenen spezifischen Algorithmen zur Erstellung des endgültigen Fotos.

Wenn Sie das nächste Mal Ihr Telefon in die Hand nehmen, die Kamera einschalten und ein Foto machen, wissen Sie, was während dieser Zeit im Hintergrund passiert ist. Interessieren Sie sich für die Funktionsweise von Smartwatches bzw. deren Sensoren?